📌 교내 '인공지능' 수업을 통해 공부한 내용을 정리한 것입니다.

🏆 ImageNet Competition

- 기존에는 전통적인 ML 로 문제를 해결하다가, AlexNet 의 등장으로 CNN 이 해당 대회에서 획기적인 성능을 보임

👻 CONV 연산 기본 (in 3D conv)

- input channel = filter channel

- filter 의 개수 = output channel

- Output feature map 의 크기 구하는 공식

- W2 = (W1 - F + 2P) / S +1

- H2 = (H1 - F + 2P) / S +1

- Maxpooling 연산 결과

- (W1 - Ps) / S + 1

- Ps 는 pooling size

1️⃣ AlexNet

* CNN 파트에 각 layer 별 연산과정이 정리되어 있습니다.

① 구조

💨 feature extraction 의 최종 output : 6x6x256

💨 flatten = 6x6x256 = 9,216 한 일차원 벡터를 FC6 에 넘겨준다.

② CONV1

- 필터의 개수 = Output channel =96

- Output feature map size = (227 - 11) / 4 + 1 = 55

③ MAXPOOL1

- Stride 이동하는 부분 체크하기!

- Max pooling 후 Output feature map size = (55 - 3)/2 +1 = 27

④ Total Number of weights

⑤ Details

🎨 AlexNet 의 특징

1. Fist use of ReLU : ReLU 라는 활성화 함수를 처음 사용한다.

2. Used Local Response Normalization (LRN) : input feature 값들을 정규화시켜줌. 요즘엔 잘 안씀

3. Data augmentation , Dropout 0.5 와 같은 정칙화 방법을 사용할 수도 있다.

2️⃣ VGG

① 핵심 아이디어

Small filters, deeper layers

⭐ CONV : only 3x3 filters at stride 1, pad 1

⭐ MAXPOOL : only 2x2 windows at stride 2

- VGG16 : 12개의 Conv, 3개의 FC, 1개의 input layer → 16개

- 현재는 VGG16이 무거워서 많이 사용되진 않음

② 왜 작은 필터 크기의 필터를 여러번 사용하는가

- 3x3 CONV 를 3번 연속으로 통과한 것 = 한번의 7x7 CONV 를 통과한 것

💨 input : 7x7 → 3x3 filter : 5x5 output → 3x3 filter : 3x3 output → 3x3 filter : 1x1 output

⭐ 비선형성을 증가시켜줌

⭐ 파라미터 개수가 줄어듦 (연산량 감소)

③ 구조

👀 계산복잡도

- 138M

3️⃣ GoogLeNet

① 핵심 아이디어

Deep layers with computational efficiency

- 정확도를 높이기 위해 Inception module 을 사용한다.

② Naive Inception Module

1. Apply parallel filters on the input from previous layer

(같은 input 에 대해 다양한 크기의 필터들을 적용시킴)

- multiple filter sizes (multiple receptive fields) + Pooling

- 여러개의 receptive field 에 대해 합성곱을 하여 더 많은 데이터를 피처로 만들게 된다.

2. Concatenate all filter outputs channel-wise

(채널방향으로 각 필터링 결과들을 연결지음)

3. But 연산량이 높고 계산 효율이 낮다는 문제점 → Sol) 1x1 CONV

❗ 계산 복잡도가 매우 높음

👀 MAC

- NN의 계산복잡도를 계산하는 표준으로 서로 다른 NN 의 계산량을 비교할 때 MAC의 개수를 가지고 비교한다.

- MAC = W2 x H2 x C x K x F x F

- 위의 계산 결과를 보면 한번의 inception module 을 통과할 때 8억 5천만번의 MAC 연산이 수행된다. 즉, 오른쪽 파이썬 코드의 loop 연산이 854M 만큼 돌아가야한다는 것 (연산 불가능)

③ 1x1 Convolution

Preserve spatial dimension, reduces depth

⭐ 핵심은 연산량을 줄이자!

- (56 - 1 + 0) / 1 + 1 = 56 : stride 1, padding 0

- information 을 고차원에서 저차원으로 압축 (summarize) 한다.

- 그러나 너무 채널사이즈를 줄이면 계산량은 감소하지만 정보의 손실이 발생할 수 있으므로 주의해야 한다.

④ Inception Module

⭐ 1x1 CONV = "bottleneck"

- concatenate 된 output channel size 는 동일한데, 중간의 연산과정에서 적은 채널의 개수로 연산이 가능해진 것이다.

- 64개의 1x1 CONV (bottleneck) 을 적용한다.

- 정확도는 감소하지만, 줄어든 연산량 대비 정확도 감소 비율은 미미함

- bottlneck 적용을 통해 2배 이상 계산 복잡도를 줄일 수 있게 된다.

⑤ 구조

👀 Classifier

- Average Pooling + 1 FC layer 를 사용

- AlexNet, VGG 는 3개의 FC layer 를 사용했었음

👀 Auxiliary Classifier

- 기울기 소실 문제를 막기 위해 보조 분류기를 중간에 추가한다.

- 이를 통해 앞부분 layer 에 대해서도 훈련을 원활하게 진행하는 것이 가능해진다.

👀 계산복잡도

- 5M → bottleneck block 을 통해 채널 사이즈를 획기적으로 줄임

3️⃣ ResNet

① 기울기 소실/폭증 문제

🤔 ResNet 말고 그냥 AlexNet 에서 layer 를 더 쌓으면 되는 것 아닌가?

◾ layer 의 개수가 증가한다고 해서 반드시 성능이 좋아지는 것은 아니다.

◾ 👻 이는 오버피팅 때문은 아니다! not because of overfitting

◾ Deeper model

👉 more representation power (할 수 있는 일이 더 많아짐)

👉 harder to optimize (training 을 잘 해내지 못한다)

💨 훈련이 안되는 가장 큰 이유 중 하나가 기울기 소실 (gradient vanishing) 문제

(1) 기울기 소실 문제 Gradient Vanishing

- gradient 값이 점차 작아져 앞쪽에 위치한 weight 들은 업데이트가 거의 발생하지 않음

- 역전파에서 입력층에 가까운 앞쪽의 layer로 갈수록 활성화 함수 sigmoid 의 미분을 연쇄적 (chain rule) 으로 곱하는데, 기울기가 1보다 작으므로 곱할수록 값은 점점 작아진다. layer가 아주 많으면 입력층에 가까운 앞쪽의 layer로 갈수록 기울기의 값은 거의 0에 가깝게 작아져서 가중치의 변화가 거의 없게 되고 error값도 더 이상 줄어들지 않게 된다.

(2) 기울기 폭증 문제 Gradient exploding

- 학습률을 크게 잡아서 gradient 값이 점차 커져 weight 값이 너무 커지게 됨 👉 loss 값이 매우 커진다.

(3) 기울기 소실문제 해결 : ReLU

- tanh 함수도 sigmoid 와 마찬가지로 기울기 소실 문제를 일으킨다.

- ReLU 는 음수가 아니라면 0에서 무한대까지 다양한 미분 값을 취할 수 있기 때문에 gradient 값이 소실되진 않는다. 따라서 기울기 소실 문제를 방지하기 위해 ReLU 함수가 널리 쓰인다.

🧐 기울기 소실 문제가 해결되면 정확도가 감소되지 않고 신경망의 layer 를 깊게 쌓을 수 있다.

② 핵심 아이디어

(1) 원 논문에서 주장하는 바

결과적으로 ResNet 이 기울기 소실 문제를 없애주기 때문에 layer 를 늘릴 수 있었고 그래서 성능이 좋아질 수 있었다.

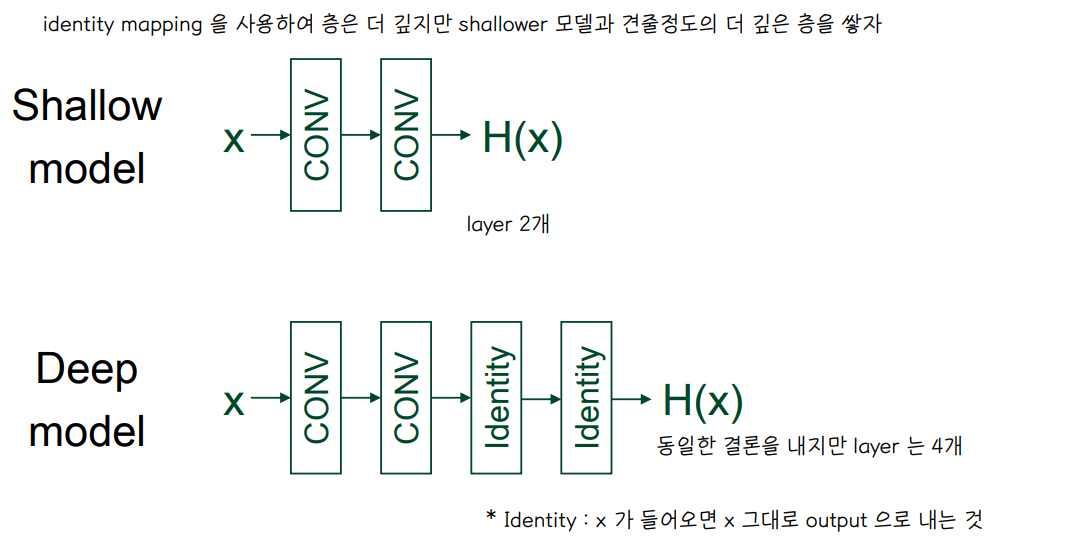

🐾 main idea : identity mapping

🐾 In layer : identity block 을 어떻게 적용할까

- H(x) 가 x가 되도록 하는 것은 어렵다

- 입력 x를 몇 layer 이후의 출력값에 더해주는 identity mapping 을 도입

- 중간 Conv 과정을 F(x) 로 두고 x를 identity mapping 하여, F(x) =H(x) - x 👉 Residual 를 0이 되도록 훈련시키는 것

- 0이라는 기준점이 있기 때문에 더 쉽다고 주장한다.

- F(x) 를 0이 되도록 학습하면 H(x) = 0 + x 가 되고 미분했을 때 1이 되어 기울기 소실 문제가 해결된다는 아이디어

💨 그러나 원 논문에서 주장하는 훈련의 쉽고 어려움의 기준이 불분명하다.

(2) 후속 논문의 정리

Residual block 이 기울기 소실 문제를 없애주기 때문에 더 쉽게 훈련할 수 있다.

⭐ Identity mapping 을 통해 gradient 가 그대로 보존되어 전달되는 통로를 만들어준다.

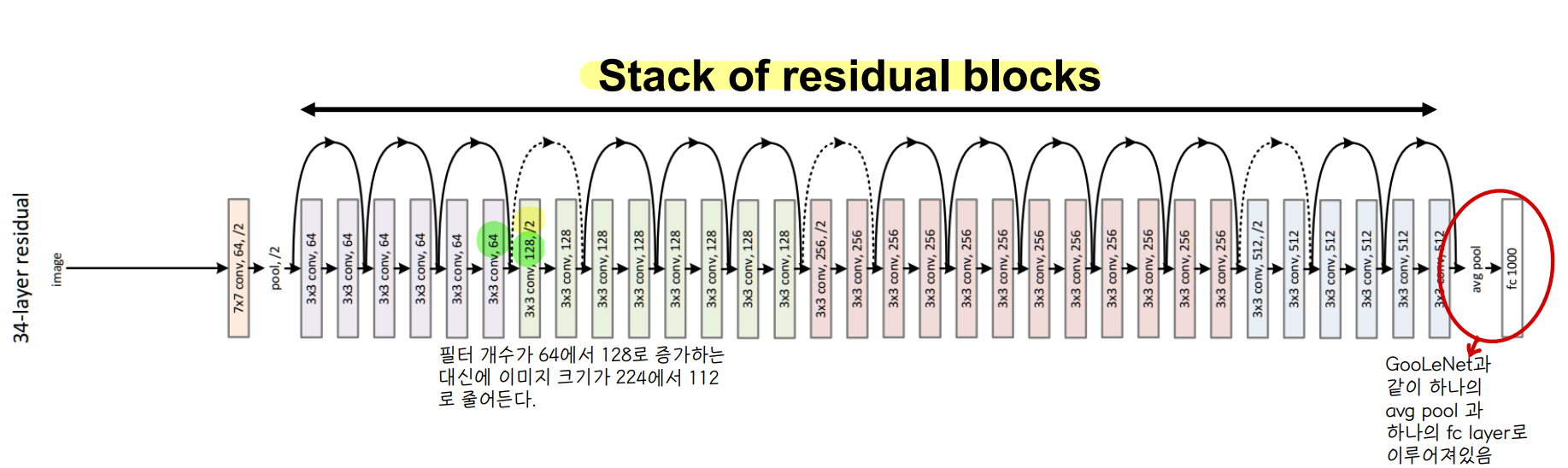

③ ResNet-34 구조

⭐ 위의 굽어가는 화살표 표시가 바로 residual block 에서의 identity mapping 에 해당함

1. 하나의 residual block 은 두 개의 3x3 CONV layer 를 가지고 있다.

2. 주기적으로 필터의 개수 (k) 를 2배로 늘리고, 그 대신 feature size 를 downsamping (pooling) 하는데 stride = 2 를 적용한다.

a. 예를들어 그림의 초록색 부분처럼 필터 개수가 64에서 128로 늘어난 대신 이미지 크기는 가령 224면 112로 줄어든다.

b. stride 2 → 연산량은 1/4 감소 (가로 길이 1/2, 세로길이 1/2) , 필터개수 2 →연산량 2개 증가 💨 최종 연산량은 1/2 감소한다.

3. Avgpool + 1 FC layer 가 뒷단에 위치한다.

④ Bottleneck Design

👉 신경망의 복잡도를 낮추어 연산 효율을 높이기 위해 bottleneck layer 를 사용한다.

- 1x1 CONV layer 가 오른쪽과 같이 신경망의 시작과 끝에 추가된다. 1x1 CONV 는 신경망의 성능을 감소시키지 않고 파라미터 수를 감소시킨다.

- bottleneck 으로 연산량을 감소시켜 34 layer 는 50 layer ResNet 이 된다.

- VGG-16 보다 ResNet-152가 더 적은 연산량을 가진다.

👀 FLOPs

- MAC 과 유사하게 연산량을 나타내는 지표에 해당한다.

- 1 MAC = 2FLOPs

⑤ 비교

👉 ResNet 이 연산량이 적고 정확도가 높다.

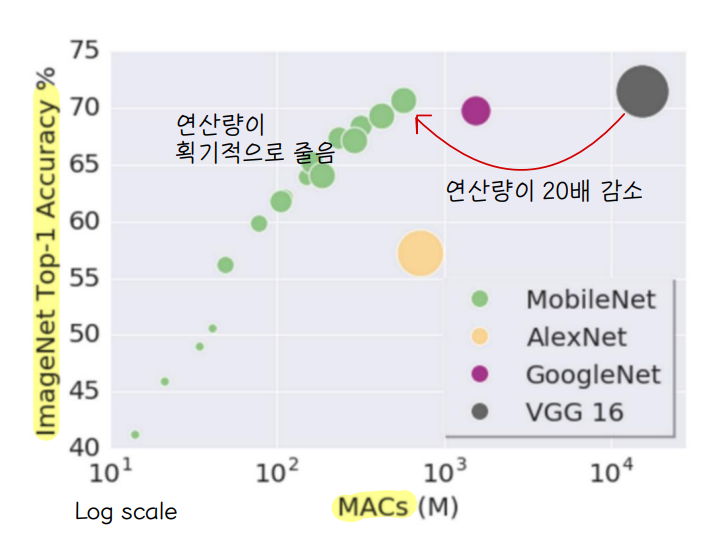

4️⃣ MobileNet

① 등장 배경

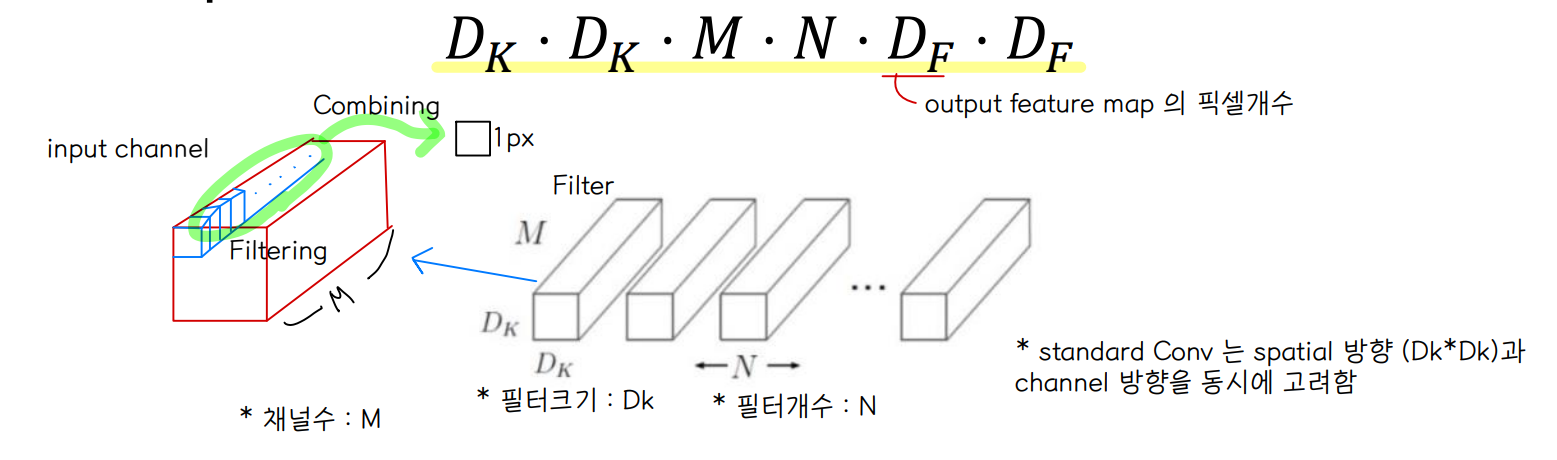

Standard convolution

- 일반적인 convolution 연산은 filtering featrues & combining features 를 통해 하나의 pixel 을 만든다.

- 따라서 Computational Cost 는 Dk x Dk x M x N x Df x Df 로 도출된다.

- Df 는 output feature map 의 size , Dk 는 filter size, M 은 채널수, N 은 필터개수

* filtering & combination 참고 (M=1 인 경우)

🤸♀️ 33, 2, -12 연산 결과도출 손으로 직접 계산해보기

(하나의 stride 에 대해 각 채널별 합성곱을 거쳐, 결과를 모두 더해 하나의 output 결과 도출)

* Computational Cost 참고

② 핵심 아이디어

filtering 부분과 combination 부분을 분리하면 연산량을 줄일 수 있다.

Depthwise Conv + Pointwise Conv 👉 Depthwise separable convolution

⭐ 공간정보 (depthwise) 와 채널정보 (pointwise) 로 분리했음

(1) Depthwise

- 각 입력 채널에 대하여 독립적으로 3x3 conv 하나의 필터가 연산을 수행하여 하나의 피쳐맵을 생성

- 즉, 입력 채널 수가 M 개이면 M 개의 피처맵을 생성하게 된다.

- 👀 그러니까 위의 참고 그림에서 '하나의 stride' 단위로 input feature 채널에 대해 연산을 수행해서 output 을 차례로 도출하는 것이 아니라, 각 input feature 채널에 대해 CONV 연산을 진행해서 각 연산 결과의 덧셈없이! 그냥 하나의 피처맵을 생성하는 것,,! 독립적으로..! (🙄)

(2) Pointwise

- depthwise 에서 생성한 각 피처맵을 concatenate 한 후 1x1 CONV 로 채널수를 조정한다. 모든 채널에 대해 연산을 진행한다.

👻 물론 이러한 방식은 standard conv 보다 정보의 손실이 더 발생하므로 정확도가 낮다. 그러나 연산량 대비 감소폭은 적어서 많이 사용된다.

③ 구조

④ 활용

- 휴대폰, IoT 같은 작은 크기의 프로세서, 메모리를 가진 on-device inference 에 최적화된 네트워크이다.

- 계산복잡도를 줄였기 때문에 정확도 감소가 조금 존재한다.

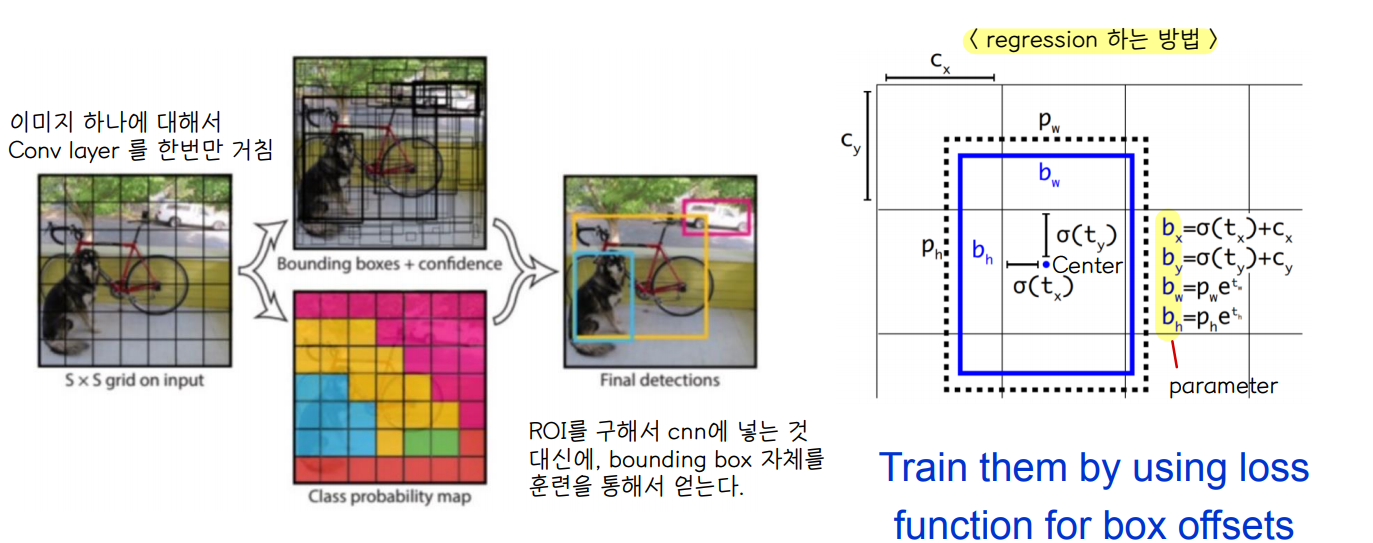

5️⃣ YOLO

① 등장 배경

(1) YOLO 의 쓰임

- object detection , 이미지에서 사물을 인식하는데 사용되는 네트워크로, 사물에 bounding box 를 쳐준다.

- (앞서 소개된 네트워크들은 이미지 분류에 사용됨)

(2) YOLO 이전에 사용했던 모델 : fast RCNN

- ROI : region of interest 로 사물이 있을 가능성이 높은 부분을 bounding 한 것이다. 하나의 이미지에 대해 이를 여러개 생성하고 그것을 CONV NN 에 입력해준다.

- 😥 이미지 한 장에 대해 사물인식을 하기 위해서 ROI 를 여러개 생성하여 CONV 연산을 수십번 진행하다보니 연산량이 많아져 네트워크 속도가 느려지는 단점이 존재한다.

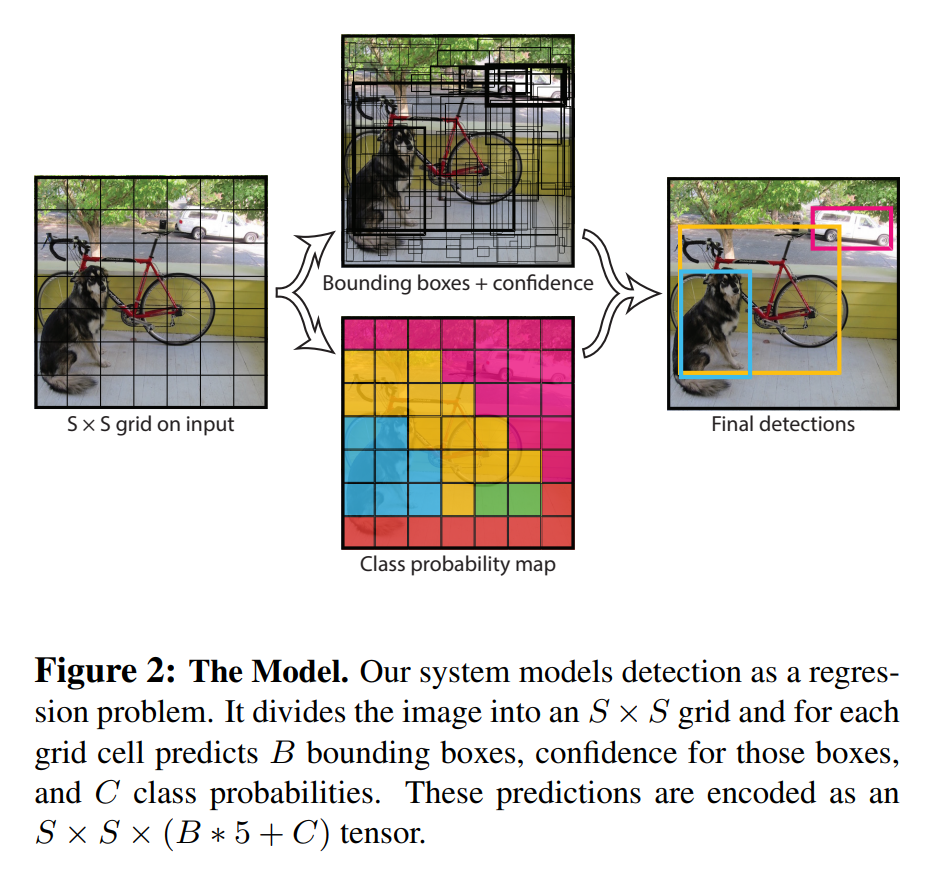

② 핵심 아이디어

Fast RCNN 의 속도가 느린 문제를 해결하기 위해 등장한 모델

- SxS 로 입력 이미지를 grid 로 나누고 grid 내에서 bounding box 를 regression 해준 다음에 가장 confidence 가 높은 bounding box 를 최종 결과로 내놓는다.

- 더불어 각 grid 마다 class probability map 을 도출시킨다.

- 이를 통해 ⭐ 이미지 하나에 대해서 CONV layer 를 한번만 거치게 하여 속도를 개선한다. (즉, 이미지를 한번만 보고 예측 가능)

- ROI 를 구해서 cnn 에 입력하는 대신에 bounding box 자체를 훈련한다.

③ 구조

- 하나의 이미지에 대해 단일한 CNN 구조를 사용하므로 속도가 빠르다 👉 실시간 객체 검출이 가능하다.

- 3가지 scale 에 대해 detection 을 수행하여 정확도를 높인다.

- 아래의 그래프를 보면 YOLO 모델의 훈련 속도가 가장 빠른 것을 볼 수 있다. 그러나 속도를 개선한 대신 정확도를 잃는 단점이 있다.

④ 한계점

1. 각 grid cell 마다 bounding box 를 2개밖에 예측하지 못한다.

2. 클래스 개수는 1개만 예측이 가능하다.

👉 때문에 grid 내에 사물이 여러개가 있는 경우에는 detection 을 1개밖에 해내지 못하기 때문에 제한적이다.

3. 만약에 새로운 이미지가 주어졌을 때 dataset 에 없는 bounding box 크기가 존재한다면 이는 잘 동작하지 않게 된다.

💡 ResNet 이 현재로서는 가장 좋은 모델이다. 네트워크를 사용하기전에 논문을 꼭 읽어보자...

'1️⃣ AI•DS > 📒 Deep learning' 카테고리의 다른 글

| [인공지능] RNN (0) | 2022.06.07 |

|---|---|

| [인공지능] Regularization (0) | 2022.04.26 |

| [인공지능] Training CNN (0) | 2022.04.26 |

| [인공지능] CNN (0) | 2022.04.23 |

| [인공지능] DNN (0) | 2022.04.23 |

댓글