Vanishing Gradients and Fancy RNNs

💡 주제 : Vanishing Gradients and Fancy RNNs

📌 핵심

- Task : 문장이 주어질 때 지금까지 나온 단어들 이후에 나올 단어를 예측

- Sequential data : 순서가 의미 있으며 순서가 달라질 경우 의미가 손상되는 데이터로 순환신경망을 사용하는 이유는 입력을 순차데이터로 받거나, 출력을 순차 데이터로 내기 위해서다.

- RNN : 다음에 올 단어를 예측하는 과제를 효과적으로 수행하기 위해 도입한 NN 의 일종 👉 문제점 : 기울기소실/폭증, 장기의존성

- LSTM : RNN 의 장기의존성의 문제점을 보완해 등장한 모델 👉 cell state , 3 개의 gate 개념을 도입

1️⃣ Language model, RNN 복습

1. Langauage model

✔ 정의

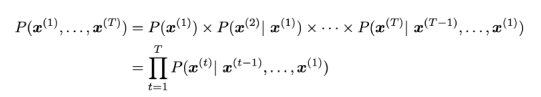

- 확률분포를 기반으로 주어진 문맥 이후에 위치할 단어를 예측한다.

- 확률의 곱셈법칙에 의해 시퀀스 결합확률을 도출한다.

2. N-gram, NNLM

✔ N-gram

- unigram, bigram, trigram 등 이전에 등장한 n 개의 단어를 통해 count 빈도를 기반으로 조건부 확률을 계산한다

- 💨 Sparsity 문제 : n-gram 범위 내의 단어가 문서 내에서 등장하지 않은 경우, 조건부확률의 분자나 분모 값이 0 이 되는 문제

✔ NNLM

- window size 이전 단어를 바탕으로 예측을 수행한다.

- n-gram 과 유사한 방식이나 확률값을 연산하는 과정에서 차이가 존재한다.

- word embedding : distributed representation (임베딩 공간 상에서 비슷한 의미를 가진 단어들은 비슷한 공간에 위치할 것이다)

- 💨 window size 가 커지면 파라미터 수가 증가하여 연산량이 늘어나고 과적합될 가능성이 존재

✔ 두 방법의 공통적인 한계점 😥 : 입력길이 (N, windowsize) 가 고정되어 한정된 길이의 단어만 살펴보기 때문에, 모든 문맥에 대한 고려는 배제한다.

3. Vanilla RNN (기본 RNN)

💥 ngram 과 NNLM 의 단점을 극복하여, 입력 길이에 제한을 두지 않는 모델이 등장

✔ RNN Architexture

① input word sequence 원핫벡터 👉 단어사전 개수만큼의 크기를 갖는 원핫벡터가 입력된다.

② Word embedding e(t) = E*x(t) 👉 embedding matrix E 와 입력 원핫벡터 x가 곱해져 embedding 표현식의 벡터 e 를 생성해낸다.

③ Hidden state vector h(t) = sigmoid(Wh*h(t-1) + We*e(t) + b1) 👉 이전 단계의 hidden state 와 Wh 벡터를 곱한 값과, 현재 단계의 (We 가중치 행렬과 임베딩 단어벡터 e 를 곱한) hidden state vector 를 더하여 시그모이드 연산 수행

④ output distribution y(t) = softmax( U*h(t) + b2 ) 👉 weight matrix U 와 hidden state 를 곱하여 소프트맥스 연산을 통해 최종 output vector 를 반환한다. 이때 output vector 값이 나타내는 것은 해당 단어가 다음 단어로 등장할 확률값이다.

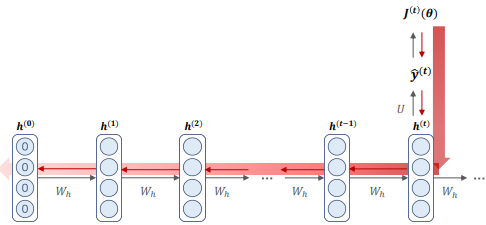

⭐ 순차적으로 입력값 x(1), x(2), ... 이 들어감에 따라 단계별로 다음에 위치할 단어들을 차례로 결정하게 된다.

⭐ RNN 의 중요한 구조적 특징 : 각 단계별로 동일한 weight matrix E, We, Wh, U 를 적용한다.

✔ 손실함수

👀 many-to-many RNN

- x(t) : 입력값

- y(t) : 다음에 위치할 단어의 예측값

- U : 최종적인 출력벡터를 반환하기 위해, hidden state 와 만나는 가중치행렬

- Wh : 현재 시점의 hidden state 를 도출하기 위해, 이전 시점의 hidden state 와 만나 연산이 이루어지는 가중치 행렬

- We : 현재 시점의 hidden state 를 도출하기 위해, 임베딩된 벡터와 만나 연산이 이루어지는 가중치 행렬

👀 loss function

- 단어를 예측하는 분류 문제에 해당하므로 손실함수는 cross-entropy 로 정의된다.

- many-to-many RNN 구조에서 각 time step 별로 loss function 값이 도출되고

- 모든 단계의 loss function 을 평균내린 값이 최종 RNN 모델의 loss 에 해당한다.

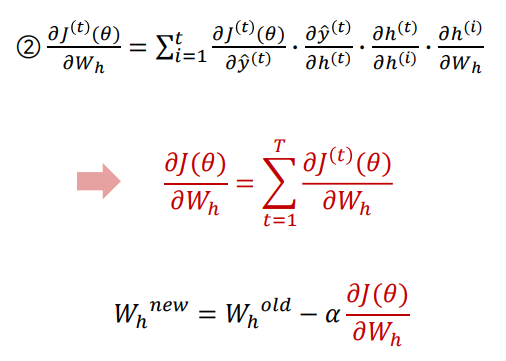

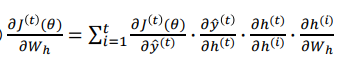

👀 BPTT : back propagation through time

- RNN 의 역전파는 BPTT 방식으로 이루어진다. 일반적인 MLP 역전파 과정과 유사하지만, 매 time step 별 입출력이 존재한다는 중요한 특징을 고려하여 계산한다는 차이점이 존재한다. (② 번 과정 참고 - time step 을 모두 고려하여 summation 연산)

- chain rule ⭐

2️⃣ LSTM

1. Problem of RNN

✔ 첫번째 문제 : Vanishing/Exploding Gradients

👀 기울기 소실

- BPTT 연산에서 loss function 의 Wh 에 대한 미분연산시, hidden state 사이의 편미분 연산 과정에서 기울기 소실/폭증 문제가 발생한다.

- BPTT : 각 레이어마다 동일한 위치의 weight 에 해당하는 모든 error 미분값을 더한다음 역전파하여 한번에 업데이트하는 방법

- 동일한 가중치 Wh 를 공유하기 때문에 Wh 가 1보다 작은 경우 반복적으로 곱해지는 값이 0에 가까워져 기울기 소실문제가 발생하고, Wh 가 1보다 큰경우는 값이 기하급수적으로 커져 기울기 폭증 문제가 발생한다 👉 파라미터 업데이트가 어렵거나 불가능해진다.

👀 기울기 소실이 문제가 되는 이유는 👉 Context 반영이 어려움

① 가까운 Gradient 의 효과만 반영한다. 즉, Near-effects 만 반영되고 Long-term effects 는 무시된다.

② Gradient 는 미래 시점에 대해 과거가 얼마나 영향을 미치는지에 대한 척도인데, gradient 가 소실되면 Step t 와 Step (t+n) 사이에 의존성 dependency 가 없어서 0이 된 것인지 파라미터를 잘못 구해 0이된 것인지 구분할 수 없게 된다.

👀 기울기 소실 문제가 Language Model에서 발생시키는 문제 : LM Task

👉 멀리있는 단어들 사이의 dependency 를 학습하지 못하는 문제가 발생

- 기울기 소실 문제로 예측할 곳과 거리가 먼 정보를 잘 전달받지 못해, 본래 정답은 ticket 이지만, 가장 최근에 나온 문장으로 잘못된 정답인 printer 로 예측함

- 원래 정답은 writer 를 따라 is 가 되어야 하지만, 멀리 위치한 단어에 대한 정보가 줄어들어 가장 가까운 books 를 보고 are 이라고 잘못 예측한다.

👀 기울기 소실 문제를 해결하는 다양한 방법들

① 다른 활성화 함수의 사용

- 동일한 가중치를 사용함으로써 발생하는 기울기 문제를 완화하기 위해 RNN 은 hidden state 를 도출할 때 사용하는 활성화함수로 시그모이드가 아닌 하이퍼볼릭 탄젠츠 함수를 채택한다.

- 시그모이드 미분값은 0에서 0.25 사이의 값을 가지므로 0에 가깝기 때문에 기울기 소실 문제가 발생할 수 있음

- 반면, Tanh 미분값은 0과 1사이의 값을 가지므로 sigmoid 보단 기울기 소실 문제에 더 강함

- 기울기 소실 문제를 막기 위한 가장 좋은 활성화 함수는 ReLU 이다.

② Gradient Clipping

- 기울기 폭증 문제의 해결책 (매번 학습률을 조절하는 것은 매우 어려움)

- gradient 가 너무 커지면 SGD update step 도 너무 커진다.

- 너무 큰 learning rate 을 사용하면 한 번 업데이트 step 의 크기가 너무 커져 잘못된 방향으로 학습 및 발산한다. 그러나 learning rate 를 작게하면 학습 속도가 너무 느려진다.

- 💨 해결책 : gradient 가 일정 threshold 를 넘어가면 gradient L2 norm 으로 나누어주는 방식

- 일정 값이 넘어가면 gradient 값을 커팅하는 것!

- 손실함수를 최소화하기 위한 기울기 방향은 유지한채로 크기만 조절한다.

③ In CNN, FN : 기울기 소실을 방지하기 위해 다양한 Connection 방법 고안

- ResNet 👉 Residual connection 개념을 도입해 input x 에 convolution layer 를 지나고 나온 결과를 더해 과거의 내용을 기억할 수 있도록 한다 : 기존에 학습한 정보 보존 + 추가적으로 학습한 정보

- DenseNet 👉 Dense connection 개념을 도입해 이전 layer 들의 feature map 을 계속해서 다음 layer 들의 입력과 연결하는 방식 : concatenation

- HighwayNet 👉 Highway connection 내념을 도입해 output 이 input에 대해 얼마나 변환되고 옮겨졌는지 표현

🤔 기울기 소실 문제는 뾰족한 해결책이 ◽◽◽

✔ 두번째 문제 : Long Term Dependency 장기의존성

- 시퀀스의 길이가 긴 경우, 시퀀스 초반의 정보가 hidden state 를 도출하는데 까지 전달되기가 어려워 long term dependency 를 잘 반영하지 못하게 된다.

2. LSTM ⭐⭐

🤨 gradient 가 0에 가까워지는게 문제면

정보를 저장하는 메모리를 따로 두어서 gradient 값이 소실되지 않도록 하면 되지 않을까?

- RNN의 문제는 멀리 있는 정보를 제대로 학습하여 결과에 반영해낼 수 없다는 점 👉 만약 멀리 있는 정보를 저장할 수 있는 별도의 메모리가 있다면 😲

✔ Long Short - Term Memory RNN

- RNN 에서 메모리를 분리해 따로 정보를 저장함으로써 앞단의 데이터도 함께 고려하여 출력을 만들고자 한 모델로 이전 단계의 정보를 memory cell 에 저장하여 흘려보낸다.

- simple RNN 의 경우 오직 hidden state 하나만을 가지고 모든 time step 의 정보를 저장하고자 했다면, LSTM 의 경우엔 크게 2가지 구조를 통하여 RNN 과의 차별점을 두고 있다.

- 이전 정보를 계속해서 전달하는 Cell state 와 불필요한 정보를 걸러주는 Gate 가 존재 → 현재시점의 정보를 바탕으로 과거의 내용을 얼마나 잊을지 곱해주고 그 결과에 현재 정보를 더해서 다음 시점으로 정보를 전달한다.

① hidden state 를 통해 단기기억을 조절하고 cell state 를 통해 장기기억을 조절한다.

② forget, input, output 3개의 gate 를 통해 매 time step 의 cell state 와 hidden state, input 에서 취할 정보의 양을 결정한다.

✔ 개념 정리

Cell state

- time step 에서 hidden state h 와 cell state c 를 가진다 💨 길이가 n 인 벡터

- Cell 은 장기기억을 저장한다.

- LSTM 은 cell 에 정보를 지우거나, 쓰거나, 읽어올 수 있다 💨 3개의 gate 로 관리

- 각 timestep 에서 gate 의 각 요소들은 시그모이드 함수를 통과함으로써 open(1), closed(0) 혹은 그 중간 값을 가질 수 있다.

Gate 💨 길이가 n 인 벡터

- input gate : 무엇을 쓸 것인가

- output gate : 무엇을 읽을 것인가

- forget gate : 무엇을 잊을 것인가

✔ Architecture

- LSTM 은 총 3가지 gate 를 두어서 입력정보의 흐름(flow) 을 결정하고 이를 통해 장기기억을 보존하는 cell state 와 단기기억을 보존하는 hidden state 총 2가지 state 들을 반환하게 된다.

① forget gate layer

◽ 어떤 정보를 반영할지 결정하는 gate

- 이전 단계의 cell state 에서 어떤 정보를 잊고, 어떤 정보를 Cell state 에 흘려넣을지 결정한다.

- 입력 정보 (새로운 입력 시퀀스 단어와 이전 시점의 hidden state) 에 시그모이드를 취하여 0~1사이의 값을 반환한다.

- 0 : 저장된 이전 정보를 지운다.

- 1 : 저장된 이전 정보를 보존한다.

💨 x 값과 이전시점의 hidden state 를 입력받아 sigmoid 함수를 통해 0과 1사이의 값을 출력한다. 0에 가까울수록 완전히 잊고, 1에 가까울수록 정보를 많이 흘려넣게 된다.

② input gate, new cell content

👉 input gate : 입력정보에 시그모이드를 취한다.

- 새로운 정보가 Cell state 에 저장될지 결정하는 Gate

- input 에 중요한 정보가 있다면 이전 단계의 cell state 에 넣는 역할을 수행한다.

- i(t) 값이 1에 가깝게 나오면 새로운 정보에 대해 반영을 많이 하고, 0에 가까울수록 잊는다.

👉 new cell content : 입력정보에 tanh 를 취한다.

💨 sigmoid layer (input gate) : 어떤 값을 업데이트할지 결정한다.

💨 Tanh layer (update gate) : cell state 에 더해질 벡터를 만든다.

③ Update Cell state

- t 번째 timestep 까지의 장기기억을 전달하는 state

👉 forget gate : 이전 시점의 cell state 에서 어느정도의 정보를 가져갈건지 결정 = 과거의 정보를 반영할지의 유무

👉 input gate : 입력 정보에서 장기 기억으로 가져갈 정보의 양을 결정 = 새롭게 발생한 현재의 정보를 반영할지의 유무

- f(t) * C(t-1) : 이전 시점의 cell state 와 만나서 전 시점으로부터 전달되어온 장기기억으로부터 어느정도의 정보량을 가져갈 것인지 결정한다.

- i(t) * ~C(t) : 새롭게 입력된 값에서 장기기억으로 가져갈 정보의 양을 결정한다.

⇒ 이 두 값이 더해져 다음 cell state 의 입력으로 들어간다 (update)

🧐 forget gate 가 1이고 input gate 가 0일 때 Cell 정보가 완전히 보존되어 장기의존성 문제를 해결할 수 있지만 여전히 기울기 소실 문제의 완전한 해결은 보장하지 않는다.

④ Output gate, hidden state

👉 output gate : 입력 정보에 시그모이드를 취한다.

👉 hidden state: 현재 입력과 대비하여 장기기억 Ct 에서 어느정도의 정보를 단기기억으로 사용할지 결정 → 다음 state 의 input 으로 들어간다.

✔ LSTM 이 기울기 소실 문제를 해결하는건가

- 여러 timestep 이전의 값도 저장하기 쉽게 해주는 구조 👉 forget gate 가 모든 timestep 값을 저장하도록 설정된다면 cell 내부의 정보는 계속 저장된다.

- LSTM 도 기울기 소실/폭증 문제가 없다고 보장할 수는 없으나, 이러한 문제를 피하기 쉬운 모델인 것은 맞다.

3️⃣ GRU

1. Gated Recurrent Units

✔ idea

- LSTM 의 구조를 조금 더 단순화시키자

- LSTM 의 변형된 모델로 Reset Gate (rt) 와 Update Gate (zt) 2개의 gate 로 이루어져 있다.

- GRU 의 계산 속도가 LSTM 보다 빠르고 파라미터 수가 더 적다. LSTM 의 장기 의존성 문제에 대한 해결책을 유지하면서 은닉상태를 업데이트 하는 계산량을 줄인 것이다.

✔ Architecture

👀 Reset gate : 이전 정보를 어느 정도 반영할 것인지 결정 rt

👀 Update gate : 과거와 현재의 정보 반영 비중을 결정 Zt

- Zt : LSTM 의 forget gate 와 input gate 를 합친 부분

💨 LSTM 의 forget 의 역할이 rt 와 zt 두 개로 나뉘어진 구조

💨 출력값 (ht) 를 계산할 때 추가적인 비선형 함수를 적용하지 않는다.

2. LSTM vs GRU

- 장기기억에 좋다.

- GRU 는 파라미터가 LSTM 보다 적어 학습 속도가 빠르고, LSTM 은 기본적으로 선택하기 좋다. 기본 모델로 LSTM 을 사용해보고 효율성을 원하면 GRU 를 시도해보면 좋을듯!

4️⃣ More Fancy RNNs

1. Bidirectional RNNs

✔ 정의

- 과거 상태 뿐 아니라 미래의 상태까지 고려하는 모델

- 양방향 정보를 모두 이용하기 위한 RNN 구조

✔ Architecture

💨 양방향 RNN 은 하나의 출력을 예측하는 데 메모리 셀 두 개를 사용한다.

- Forward RNN : 정방향으로 입력받아 hidden state 를 생성

- Backward RNN : 역방향으로 입력받아 hidden state 를 생성

- 두 개의 hidden state 가 서로 연결되어 있지는 않고, 입력값을 각 hidden layer 에 전달하고 output layer 도 이 두 hidden layer 로부터 값을 받아서 최종 Output 을 계산하는 구조를 가지고 있다.

✔ Note

- 양방향 RNN 은 전체 entire input sequence 가 주어졌을 때만 적용할 수 있다. Language modeling 의 경우에는 left context 만 접근 가능하므로 적용할 수 없다.

- entire input seqence 가 있다면 bidirectionality 는 더 강력하게 작용한다.

- 👀 BERT 👉 Bidirectional Encoder Representations from Transformers : powerful pretrained contextual representation system built on bidirectionality

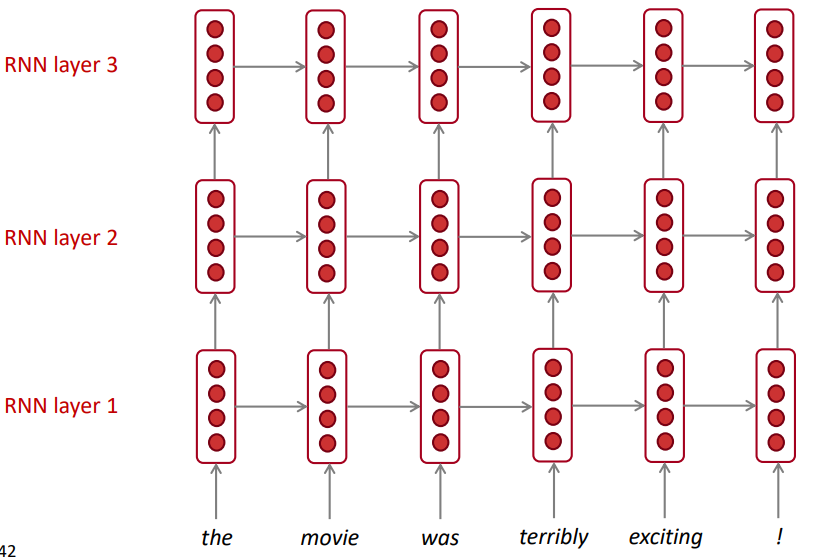

2. Multi-layer RNNs

✔ 정의

- RNN 을 여러 층으로 사용한 모델

- 더 복잡한 표현과 특성을 학습할 수 있도록 한다. 기울기 소실 문제 때문에 일반적으로 2~4개의 층을 쌓아 사용한다. (더 많은 층을 쌓는 것은 권장하진 않음)

- BERT 와 같이 Transfoermer-based network 의 경우엔 24개의 layer 까지 쌓을 수 있다.

📌 실습 자료

① LSTM

-

② GRU

-

③ Fancy RNNs - bidirectional, multi layer

- https://wikidocs.net/22886 👉 model.add(Bidirectional(SimpleRNN(hidden_units, return_sequences=True), input_shape=(timesteps, input_dim)))

'1️⃣ AI•DS > 📗 NLP' 카테고리의 다른 글

| [cs224n] 9강 내용 정리 (0) | 2022.05.09 |

|---|---|

| [cs224n] 8강 내용 정리 (0) | 2022.05.09 |

| [cs224n] 6강 내용 정리 (0) | 2022.03.24 |

| [cs224n] 5강 내용 정리 (0) | 2022.03.22 |

| [cs224n] 4강 내용 정리 (0) | 2022.03.18 |

댓글