💡 주제 : Language models and RNN (Recurrent Neural Network)

📌 핵심

- Task : 문장이 주어질 때 지금까지 나온 단어들 이후에 나올 단어를 예측

- RNN : 다음에 올 단어를 예측하는 과제를 효과적으로 수행하기 위해 도입한 NN 의 일종

📌 목차 / 내용

1. Language model

(1) Language model 이란

✔ 정의

- 단어의 시퀀스(문장) 에 대해 얼마나 자연스러운 문장인지를 '확률' 을 이용해 예측하는 모델

- Language modeling = 주어진 단어의 시퀀스에 대해 다음에 나타날 단어가 어떤 것인지를 예측하는 작업

- 특정 문장에 확률을 할당한다. 문장의 단어 w(1), w(2) , ... w(t) 가 주어졌을 때 다음에 올 단어 w(t+1) 의 확률

✔ 활용

- 문장의 확률 또는 단어의 등장 확률을 예측

- 기계번역, 음성인식, 자동완성(ex. 구글 검색)

(2) N-gram Language model

✔ 정의

- NN (딥러닝 모델들) 이전에 사용되었던 언어모델이다.

- 예측에 사용할 앞 단어들의 개수 (window) 를 정하여 모델링하는 방법 (이전에 등장한 n-1 개의 단어들을 이용해 다음 단어를 예측한다)

- N-gram : n 개의 연이은 단어 뭉치

- 다음에 올 단어는 이전에 등장한 단어들에만 영향을 받는다는 가정 하에, corpus 에서 counting 을 하는 방식으로 확률을 구한다.

- N-gram 문장이 나타날 확률과 (N-1) gram 이 나타날 확률을 이용해 현재 문장이 주어졌을 때 다음 단어가 올 확률을 계산해낼 수 있다. 이때 계산에 필요한 확률은 큰 corpus 에서 '출현 빈도' 를 세서 얻을 수 있다.

- N-gram 의 빈도에 대한 통계를 수집하고 이를 다음 단어를 예측하는데 사용

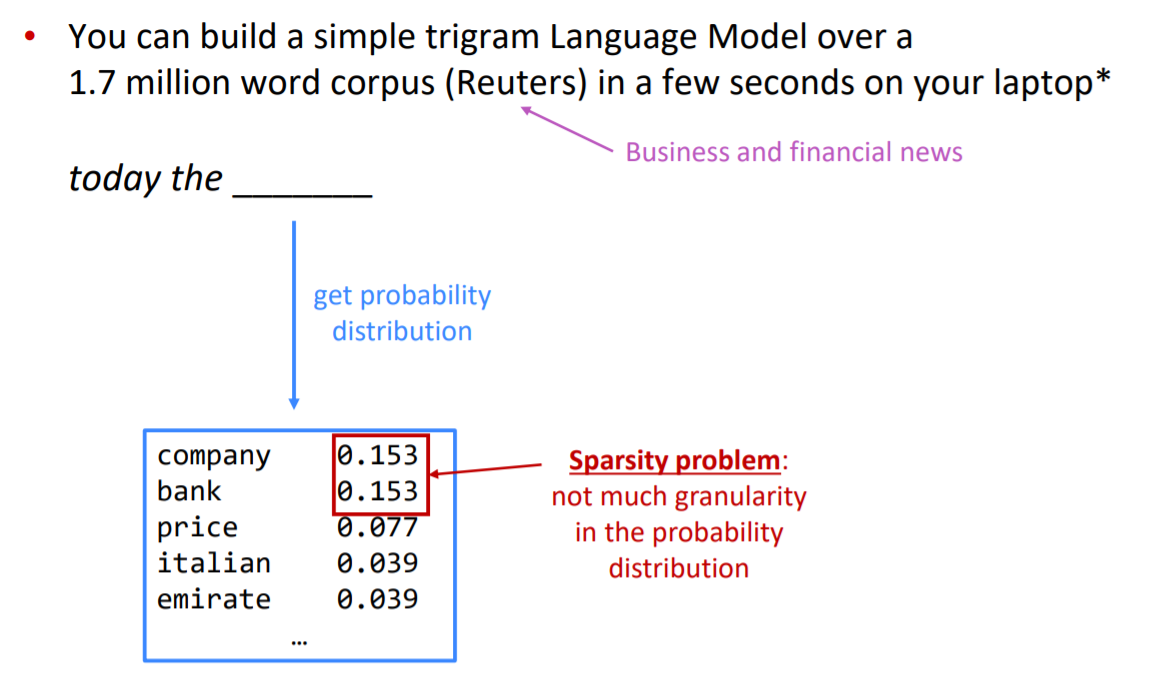

✔ 계산 예시

✔ N-gram 모델의 문제점

- Sparsity 문제 : n (window 크기) 가 커질수록 안좋아지며 일반적으로 n < 5 로 설정함

- 분모에는 smoothing 방식을 쓰지 않고 backoff 방식을 쓰는 이유 : 분모가 0인 경우가 더 심각하기 때문

2. Storage 문제

- n 이 커지거나 corpus 가 증가하면 Corpus 내 모든 n-gram 에 대한 count 를 저장해줘야 하기 때문에 모델의 크기가 증가한다. (실행이 오래걸리는 단점)

3. Incoherence 문제

🤔 N-gram 방식은 앞전 단어들만 이용하니까 context (문맥)을 담기엔 한계가 있는 것 같아!

- 다음 단어는 앞의 단어들에게만 영향을 받는다라는 가정 때문에 이전 문맥을 충분히 반영하지 못함

- 즉 다음 단어를 예측하는데 아주 중요한 정보가 그 단어와 문장에서 멀리에 위치하면 그 정보를 놓치게 됨

- N 의 크기를 늘리면 어느정도 해결할 수 있지만 sparsity 문제가 심해진다.

✔ Process 살펴보기

- 가능성 있는 단어들이 확률분포로 도출됨

- condition 조건 선택 → sampling 확률 분포에서 제일 확률이 높은 단어를 선택 → condition 조건 선택 ... 반복

(3) Window-based Neural Network Language model (NNLM)

✔ 정의

- N-gram 의 문제점인 Sparsity (충분한 데이터가 없다면 언어를 정확히 모델링 하지 못함) , Incoherence 를 해결하기 위해 제안된 신경망 기반의 모델

- 희소 문제는 기계가 단어 간 유사도를 알 수 있다면 해결할 수 있게 됨 : 훈련 코퍼스에 없는 단어 시퀀스에 대한 예측이라도 유사한 단어가 사용된 단어 시퀀스를 참고하여 정확한 예측을 수행할 수 있음 👉 이러한 아이디어를 가지고 탄생한 언어모델이 NNLM

- 다음에 등장할 단어를 예측하는 언어모델이면서 동시에 단어의 'distributed representation' (단어 벡터 표현) 을 학습한다.

- NNLM 도 N-gram 과 유사하게 정해진 n 개의 단어만을 참고해서 (윈도우 범위) 예측을 수행한다.

✨ x 의 시퀀스를 window 사이즈 만큼 입력 👉 단어를 원핫인코딩 벡터로 표현 👉 각 단어에 대해 임베딩 벡터를 뽑아내고 이를 이어붙인다 (e) 👉 hidden layer 👉 Softmax 를 통과 👉 그 다음 단어가 나타낼 '확률분포' 를 output 으로 도출

⚾ input : 단어들의 시퀀스

🥎 output : 다음 단어에 대한 확률 분포

✔ 장점

- 단어 임베딩을 통해 Sparsity 문제를 해결

- 관측된 n-gram 을 저장할 필요가 없어짐 ← 임베딩 방식을 통해 개별 확률이 아니라 전체 확률분포로 표현되기 때문

✔ 단점

- 고정된 window 크기가 너무 작다. (n<5)

- Window 크기가 커질수록 W 도 커진다 → window 크기의 한계

- 각 벡터들은 완전히 다른 가중치 W가 곱해지므로 단어와 단어 간이 No symmetry 하다는 문제점이 존재

✔ W 에서의 symmetry

➕ http://norman3.github.io/prml/docs/chapter05/1.html

- 공간 대칭성 : feed-forward 네트워크에서 서로 다른 w에 대해서도 동일한 입력에 대해 동일한 출력 결과를 만들어낼 수 있는 성질을 의미한다.

- Sign-flip symmetry : 부호만 반대인 경우엔 두 단계를 거치면 동일한 결과를 만들 수 있다.

- Interchange symmetry : 같은 레이어 내 임의의 히든 유닛 2개에 대해 서로 위치를 바꾸어도 최종 출력값은 변화가 없다.

🤨 가중치 깨짐

✔ 단어와 단어가 symmetry 하지 않다는 것의 의미

- 룩업 테이블 : 원핫벡터의 특성으로 인해 i 번째 인덱스에 1이라는 값을 가지고 그 이외에는 0의 값을 가지는 원핫단어 벡터와 가중치 W 행렬의 곱은 사실상 W행렬의 i 번째 행을 그대로 읽어오는 것 (lookup) 과 동일하다는 개념

- 룩업 테이블의 작업을 거치면 V 차원을 가지는 원핫벡터는 이보다 더 차원이 작은 M차원의 단어로 매핑이 된다. 테이블 룩업 과정을 거친 후 이 단어의 벡터를 임베딩 벡터라고 한다.

- 벡터와 가중치 행렬에서의 연산은 각 벡터들이 각각 다른 W 가중치 부분을 곱하게 되면서 각 단어들이 No symmetry 하게 되는 문제점을 가지게 된다.

👉 같은 단어가 다른 위치에 나타나면 다르게 처리된다. 단어의 위치에 따라 곱해지는 가중치가 달라지므로 모델이 비슷한 내용을 여러 번 학습하는 비효율성을 가진다.

2. Recurrent Neural Network (RNN)

(1) RNN

✔ 비교

- FFNN : 은닉층에서 활성화 함수를 지난 값은 오직 출력층 방향으로만 향하는 신경망

- RNN 은 은닉층의 노드에서 활성화 함수를 통해 나온 결과값을 출력층 방향으로도 보내면서 다시 은닉층 노도의 다음 계산의 입력으로 보내는 특징을 가지고 있다.

✔ 정의

- 시퀀스 데이터를 모델링하기 위해 등장한 모델로 기존 NN 과 다른점은 '기억(hidden state)' 를 가지고 있다는 점이다.

- 기존 신경망은 모든 입력이 각각 독립적이라고 가정했는데, NLP 에서는 이러한 가정의 적용이 옳지 않을 수 있다. 문장에서 다음에 나올 단어를 추측하고 싶다면 이전에 나온 단어들의 연속성을 아는 것 자체가 큰 도움이 될 수 있다.

- Recurrent : 직전 시점의 은닉층에서 생성된 hidden states 를 다음 시점의 input 으로 전달하는 것이 특징. 즉 출력 결과는 이전의 계산 결과에 영향을 받는다.

- 동일한 가중치 W 를 반복적으로 적용 👉 단어간의 symmetric 하지 않았던 NNLM 의 단점을 보완

#python code

hidden_state_t = 0 # 초기 은닉 상태를 0(벡터)로 초기화

for input_t in input_length: # 각 시점마다 입력을 받는다.

output_t = tanh(input_t, hidden_state_t) # 각 시점에 대해서 입력과 은닉 상태를 가지고 연산

hidden_state_t = output_t # 계산 결과는 현재 시점의 은닉 상태가 된다.

✔ 표기

👉 h의 역할을 통해 메모리(기억력) 이 있는 계층이라 부른다.

✔ 장점

- 이전의 정보들을 활용할 수 있다.

- 시퀀스 순서에 맞게 하나씩 입력해주기 때문에 입력의 길이에 제한이 없음

- 이론적으로는 길이가 긴 timestamp t 에 대해 처리가 가능하다. (어떤 길이의 텍스트이던 계산 가능)

- 매 step 마다 동일한 가중치 W가 적용되기 때문에 입력에 따른 모델의 크기가 증가하지 않는다. 모델의 크기는 Wh 와 We 로 고정되어 있다.

- 매 step 에 동일한 가중치를 적용하므로 symmetry 하다

✔ 단점

- 단어가 하나씩 입력되기 때문에 순차적인 계산이 필요하여 Recurrent 계산이 느리다.

- 정보의 손실 문제 (기울기 소실 문제) 때문에 실제로는 길이가 긴 timestep 에 대해서는 처리가 되기 어렵다. 즉, 먼 곳에 있는 단어 정보를 반영하기는 어렵다는 의미이다. = 중요한 입력과 출력 단계 사이의 거리가 멀어질수록 그 관계를 학습하기 어려워짐 👉 변형 모델인 LSTM, attention 모델이 제시

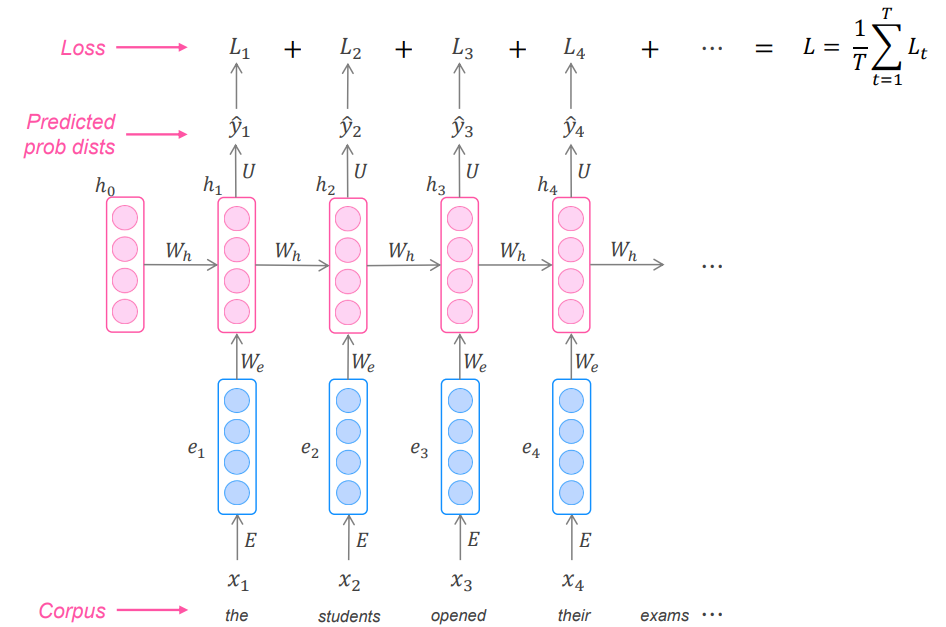

(2) RNN training

✔ 과정

1. 단어들로 이루어진 시퀀스의 corpus 를 준비한다.

2. 단어들을 순서대로 RNN 에 입력하고 매 단계 t 에 대한 출력분포를 계산한다.

3. t 단계에 대한 손실함수 Cross-Entropy 를 계산한다.

4. 전체 training set 에 대한 손실을 구하기 위해 평균값을 구한다.

* 전체 corpus 에 대한 loss 와 기울기 계산은 시간이 많이 걸리므로 실제론 문장이나 문서 단위로 입력을 주기도 한다.

* 혹은 SGD 를 통해 최적화를 하기도 한다.

✔ Backpropagation

- 기존 역전파와 다르게 순환 신경망은 계산에 사용된 시간, 시점의 수가 영향을 준다. 따라서 시간에 따른 역전파라는 BPTT 를 사용하게 된다.

- BPTT(Backpropagation Through Time) 방식 : timestep 에 따라 gradient 를 더해간다.

각 레이어마다의 weight는 실제론 동일한 웨이트여야 하므로 모든 업데이트도 동일하게 이루어져야 한다. 따라서 각 layer마다 동일한 위치의 weight에 해당하는 모든 derivative error를 다 더한다음 (더하는 거나 평균 내는거나 사실상 같은 의미) weight를 1번 업데이트 해준다.

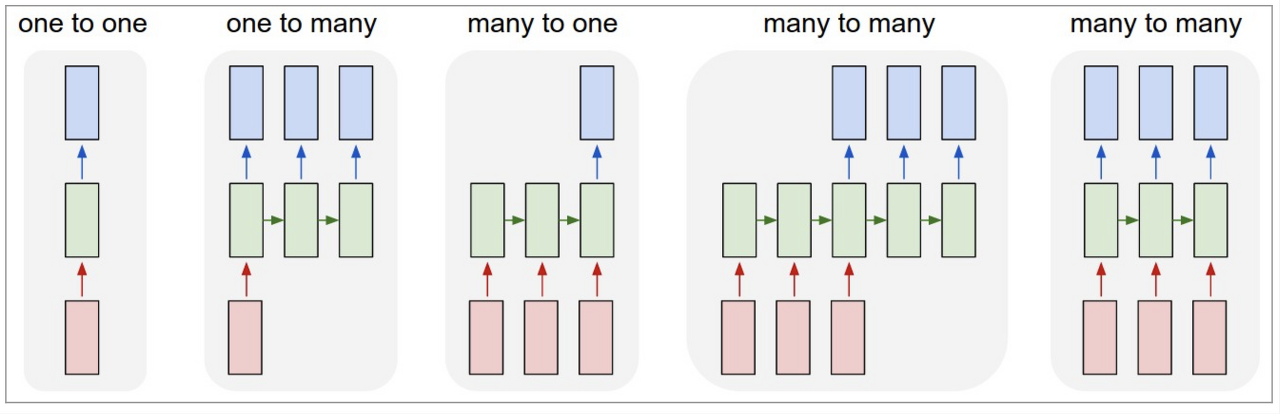

(3) RNN 의 활용

✔ RNN 의 입출력은 task 목적에 따라 얼마든지 달라질 수 있다.

- One-to-One : 순환적인 부분이 없으므로 RNN 이 아님

- One to many : 고정크기를 입력해 시퀀스를 출력한다. 예를들어 이미지를 입력해 이미지에 대한 설명을 문장으로 출력하는 이미지 캡션 생성 task 를 수행한다.

- Many to one : 시퀀스를 입력해 고정 크기를 출력한다. 예를들어 문장을 입력해 긍부정 정도를 출력하는 감정 분석기 task 를 수행한다.

- Many to Many : 시퀀스를 입력해 시퀀스를 출력한다. 예를들어 영어를 한국어로 번역하는 자동 번역기 task 를 수행한다.

- Many to Many(2) : 동기화된 시퀀스를 입력해 시퀀스를 출력한다. 예를들어 문장에서 다음에 나올 단어를 예측하는 언어 모델 task (이번 chapter 에서 다룬 내용) 을 수행한다.

✔ tagging : part-of-speech tagging, named entity recognition

✔ 문장분류/감정분류

✔ encoder module : question answering, machine translation

✔ generate text : speech recognition, machine translation, summarization

3. Evaluating

(1) Perplexity

✔ 정의

- 언어모델은 주어진 과거 단어 정보로부터 다음에 출현할 단어의 확률 분포를 출력하는 모델

- 언어모델을 평가하는 대표적인 척도가 Perplexity 👉 출현할 단어의 확률에 대한 역수

- 값이 작을수록 좋은 언어모델이라 할 수 있다.

✔ 수식 형태

- 손실함수를 도입하여 e^L 형태로 정리됨

✔ 페이스북 실험 결과

👀 더 알아보기

- 양방향 순환 신경망 : 시점 t에서의 출력값을 예측할 때 이전 시점의 입력뿐만 아니라, 이후 시점의 입력 또한 예측에 기여할 수 있다는 아이디어에 기반

📌 실습 자료

- pytorch 문자-단위 RNN으로 이름 분류하기 : https://tutorials.pytorch.kr/intermediate/char_rnn_classification_tutorial

기초부터 시작하는 NLP: 문자-단위 RNN으로 이름 분류하기 — PyTorch Tutorials 1.11.0+cu102 documentation

Note Click here to download the full example code 기초부터 시작하는 NLP: 문자-단위 RNN으로 이름 분류하기 Author: Sean Robertson 번역: 황성수 단어를 분류하기 위해 기초적인 문자-단위 RNN을 구축하고 학습 할

tutorials.pytorch.kr

- tensorflow 로 RNN 생성해보기 : https://wikidocs.net/22886

1) 순환 신경망(Recurrent Neural Network, RNN)

RNN(Recurrent Neural Network)은 입력과 출력을 시퀀스 단위로 처리하는 시퀀스(Sequence) 모델입니다. 번역기를 생각해보면 입력은 번역하고자 하는 ...

wikidocs.net

- ⭐⭐ 텍스트 생성 예제 : https://wikidocs.net/45101

6) RNN을 이용한 텍스트 생성(Text Generation using RNN)

다 대 일(many-to-one) 구조의 RNN을 사용하여 문맥을 반영해서 텍스트를 생성하는 모델을 만들어봅시다. ##**1. RNN을 이용하여 텍스트 생성하기** 예를 ...

wikidocs.net

'1️⃣ AI•DS > 📗 NLP' 카테고리의 다른 글

| [cs224n] 8강 내용 정리 (0) | 2022.05.09 |

|---|---|

| [cs224n] 7강 내용 정리 (0) | 2022.04.21 |

| [cs224n] 5강 내용 정리 (0) | 2022.03.22 |

| [cs224n] 4강 내용 정리 (0) | 2022.03.18 |

| NLP deep learning (0) | 2022.03.15 |

댓글