📌 경량화 : 딥러닝 모델 사이즈를 줄이기

- 모델 경량화는 하드웨어와 연관이 많이 되어있음

- 딥러닝 모델의 크기는 계속 커지고 있기 때문에 하드웨어에서 잘 동작시키기 위해서 관련 연구가 필요함

📌 Ever Increasing Model Size

- 모델 크기가 커지는 이유는 정확도 때문 → 모델의 크기가 커질 수록 representation power 가 증가

📌 Downside

모델 크기를 늘려 정확도를 증가시키는 것은 2가지 단점을 불러일으킨다.

- 연산량 증가

- 메모리 점유율 증가 : 메모리에 모델 파라미터를 올려서 구동 (저장) → 메모리가 작은 휴대폰, 임데디드 시스템에서는 거대한 AI 를 동작시키기 어려움

- 메모리 bandwidth 증가 : 메모리로부터 CPU 또는 GPU 로 데이터를 전송해야 하는데, 이때 전송하는데 필요한 대역폭을 의미한다. 모델이 커질수록 전송할 데이터 양이 많아지기 때문에 초당 보내야 할 데이터 양도 커진다.

📌 모델 복잡도를 줄이는 방법

◼ Quantization : 숫자 (activation, weight) 를 표현할 때 사용할 bit 개수를 적게 사용하도록 함

- 양자화

- EX. weight 하나를 표현하는데 32 bit 를 사용했다가 8bit 를 쓰면 7byte 를 덜 사용하게 된다.

◼ Pruning : 최종 정확도에 영향을 미치지 않는 중요하지 않은 weight 값은 0으로 만듦

- 가지치기

- weight 를 0으로 만들어 모델 사이즈를 줄이면서 정확도는 유지

◼ Neural architecture search : 모델 구조를 효율적으로 생성

- EX. MoblieNet → 이미지 분석 모델 중 하나로 모델 구조를 경량화 시킨 방법 중 하나

◼ Knowledge distillation : 모델 구조를 더 작게 만들도록 함

- Knowledge distillation

1️⃣ Quantization

1. Floating-Point Numbers

- activation 과 weight 값은 일반적으로 floating-point number 로 표현된다.

- 실수 값을 binary 값으로 변환

- FP32 : 표준 표현식 → sign, exponent, mantissa

- FP 16 : 16 bit 표현식

2. Quantization

👀 what Does it Mean

- bit 를 가지고 표현할 수 있는 숫자는 실수 범위에서 몇 가지 step 으로만 표현할 수 있다. (discrete)

- 양자화 : 실수 범위를 binary 표현에 맞추어 잘라준다.

- 3.09 라는 실수를 binary 로 표현한다고 가정해보자 → 3.09 는 3.08999 와 3.09000001 사이에 존재하는 값이므로 가까운 쪽으로 양자화를 시켜준다.

연속된 실수가 유한한 숫자의 discrete 한 step 중 가장 가까운 쪽으로 round 된다. discrete step 사이의 거리는 bit precision 으로 결정된다. mantissa 개수로 bit precision 을 결정한다.

👀 To Lower Bits

- FP32 로 표현했던 것을 FP 16으로 표현해보자

- 양자화 스텝이 멀어졌기 때문에, error 가 커진다.

👀 To Even lower Bits

- 더 줄이면 step 사이의 거리가 더 커져서 error 도 더 늘어난다.

3. Integer Representation

- 부동 소수점을 계산하기 위한 하드웨어는 복잡하기 때문에 power 도 늘어나게 된다.

- Integer representation : 정수만을 가지고 숫자를 표현 → 하드웨어가 더 효율적으로 동작한다.

- Integer representation : 첫번째 비트가 sign bit, 나머지는 binary 숫자

- 그러나 문제점은 weight 값이 소숫값이기 때문에 정수화 시켜주는 단계가 필요함

4. Symmetric Linear Quantization

💨 소수점으로 표현된 숫자를 (정수로) 양자화 시키는 방법

💨 symmetric quantization : 0 을 기준으로 같은 범위를 양자화 시킨다. 정확성이 조금 떨어지지만 하드웨어 측면에서 효율적이다.

💨 Asymmetric quantization : 0을 기준으로 비대칭적이다. 모든 bit 를 활용해 전 범위를 표현할 수 있어 정확도는 좀 더 좋다. 그러나 하드웨어 측면에서 비효율적이다.

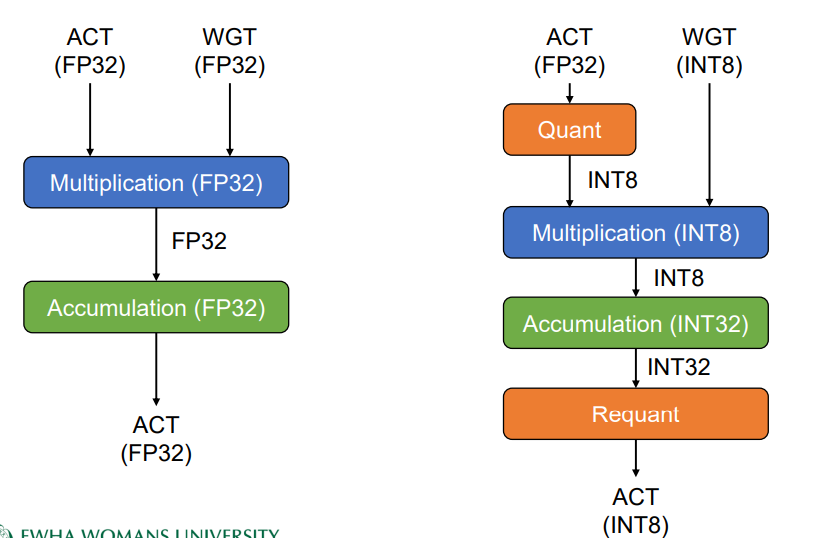

5. Quantization in Inference

◼ (왼쪽) FP 32 를 사용해 activation 과 weight 값을 표현하고 FP 32 로 연산을 진행하게 된다.

◼ weight 값은 미리 알고 있기 때문에 양자화를 통해 정수로 변환하여 입력한다. activation 은 실시간으로 무엇이 들어올지 모르기 때문에 들어오는 즉시 양자화를 진행해준다. INT 표현을 통해 연산을 진행한다.

💨 이러한 방식으로 실제 NN 에서 양자화를 사용해 적은 비트수로도 같은 NN 을 동작시킬 수 있게된다.

6. On accuracy

AlexNet accuracy

◼ FP32 → 0.559 , INT 8 → 0.530 ...

◼ 적은 비트수를 사용할수록 정확도가 감소한다.

7. Research Topics

💨 연구분야

2️⃣ Pruning

1. Pruning

◼ 학습을 하고 나서 weight 값의 일부는 매우 작다 → activation 에 곱해져도 정확도에 크게 영향을 미치지 않음 → 0 으로 만듦

◼ weight 값을 0으로 만들면 model compression 이 가능해진다. run length encoding 을 사용해 compression 을 진행한다.

◼ 빠른 연산이 가능해진다.

◼ 주의 : Dropout 은 training 과정에서 random 하게 activation weight 를 0으로 바꾸는 것이고 실제 사용할 때는 모든 weight 들을 사용한다. pruning 은 inference 할 때에도 가지치지 된 채로 활용한다.

2. 관련 연구 이슈

◼ 무조건 작은 값을 0으로 만드는게 아니라 weight 가 final accuracy 에 미치는 영향을 보아서 영향력이 없다면 해당 weight 를 0으로 만드는 것이 더 적합하다.

◼ weight 를 가지치기 하는 것이 꼭 계산 성능을 높여주는 것은 아니다. 따라서 구조화된 pruning 방식을 사용해 연산 속도를 높인다. 대신 자유도가 떨어져 정확도가 떨어질 수 있다.

◼ 하드웨어와 소프트웨어를 동시에 최적화 하는 방법

3. HW/SW Co-Design

◼ 엔비디아 최신 GPU : structured prunning

3️⃣ NAS

1. Neural Architecture Search

◼ NAS : NN 의 구조를 사람이 직접 설계하는 것이 아닌 기계가 design 하는 것

◼ 대표적인 적용 사례가 AutoML

◼ 정확도 뿐만 아니라 모델의 복잡도까지 고려해서 모델 경량화를 진행

2. The Basic NAS Approach

💨 구글 연구 : 강화학습을 이용한 모델 경량화

3. Results

💨 NAS 가 찾은 모델 구조가 더 효율적임 : 기계가 디자인하는 것이 더 좋음

4. HW-Aware NAS

💨 하드웨어의 성능을 고려해서 NN 구조를 설계

'1️⃣ AI•DS > 📒 Deep learning' 카테고리의 다른 글

| [딥러닝 파이토치 교과서] 1장 머신러닝과 딥러닝 (0) | 2022.09.22 |

|---|---|

| [Pytorch 딥러닝 입문] 파이토치 기초 (0) | 2022.09.14 |

| [인공지능] Federated Learning , Distributed Learning (0) | 2022.06.15 |

| [인공지능] Meta learning , Transfer learning (0) | 2022.06.14 |

| [인공지능] Reinforcement Learning (0) | 2022.06.14 |

댓글