📌 참고 자료 : https://www.youtube.com/watch?v=dZi6INuLyOQ

1️⃣ GPT-3

① GPT-1

📌 https://velog.io/@stapers/GPT-1-Languageunderstandingpaper

Semi-supervised : Unsupervised pre-training + supervised fine-tuning

1. Pre-train

👉 Unsupervised

: Transformer decoder 를 이용해 대량의 레이블이 없는 코퍼스로 LM 을 사전학습

2. Finetune

👉 supervised

: pretrain 된 모델을 task 에 맞게 input 과 label 로 구성된 코퍼스에 대해 지도학습을 진행

✔ Improving Language understanding by generative pre-training

- 트랜스포머 디코더만 사용

- 단방향 모델 P(wi) = P(wi | w0, ... , w_i-1) 👉 이전까지 주어진 단어들로 현재 단어를 예측

- 일반적인 LM 을 통해 pre-train 을 진행

- LM 은 레이블이 필요 없다 👉 대량의 데이터 확보 가능

- Train data size : BooksCorpus (800M words)

- Teacher Forcing 을 이용 : target word(Ground Truth)를 디코더의 다음 입력으로 넣어주는 기법

✔ Task

- Classification : 긍/부정, 문법 오류 여부

- Entailment : 주어진 문장들의 관계 분류

- Similarity : 두 문장 간 의미적 유사도 파악

- Multiple Choice : 주어진 문제에 대한 보기 중 정답 고르기

👻 pre-train 은 LM 으로 진행되었으므로 각 task 와 input 모양이 다를 수 있다는 문제점 존재

→ 각 task 의 input 을 GPT-1 에 실을 수 있도록 input 을 위와 같은 모양으로 변형함 (파랑보라 부분)

② GPT-2

📌 https://lsjsj92.tistory.com/620

✔ LM are Unsupervised Multitask Learners

fine tuning 단계가 더 이상 필요없어진 LM 👉 범용적인 LM 을 만들자

- 기본 구조는 GPT-1 과 동일

- zero shot learning : 모델이 바로 downstream task 에 적용

*One-shot learning : downstream task 를 한 건만 사용

*Few-shot learning : downstream task 를 몇 건 사용

🙄 HOW ?

- task 정보를 함께 입력으로 넣어준다.

- 적절한 task description 을 입력으로 함께 넣어주면 fine tuning 과정 없이 정답을 잘 생성해내게 된다.

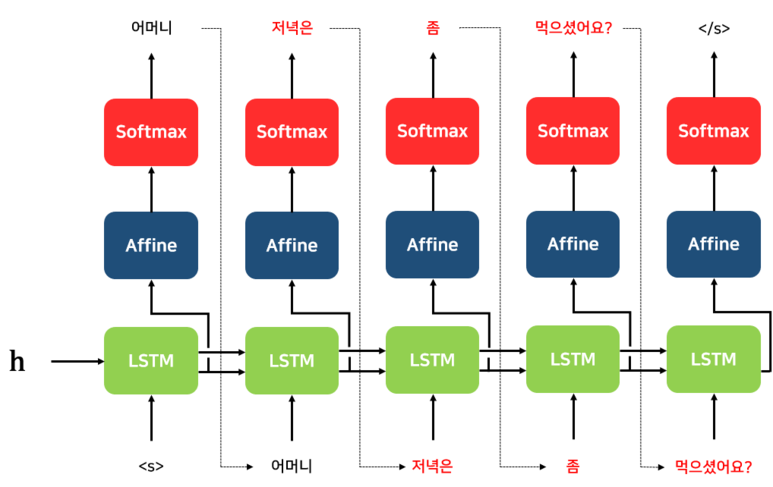

✔ Auto regressive

- 이전 output 이 다음 input 으로 들어감

➕ Byte pair encoding 활용 : 글자와 단어의 중간 단위 subword 를 사용할 수 있음 , OOV 문제 해결

③ GPT-3

📌 https://www.technologyreview.kr/gpt3-best-worst-ai-openai-natural-language-2/

Open-AI 가 제작한 대형언어모델

✔ LM are Few shot learners

- task 에 대한 정보를 입력

- GPT-2 와 달리 특별히 몇 가지 예제를 입력으로 넣어줌 👉 Few Shot

✔ Large LM

- 엄청나게 많은 양의 데이터를 학습 시켰으며 크기가 매우 크다.

✔ Sparse attention pattern

- GPT-2 와 구조적으로 큰 차이는 없으나 attention 을 주는 부분에서 토큰 간 attention 을 전부 할당하면 계산량이 많아지는 것을 방지하기 위해 sparse 하게 attention 을 주는 부분에서 차이가 존재한다.

✔ Meta-learning

- 사람이 통제하던 기계학습 과정을 자동화하여 기계가 스스로 학습 규칙, 즉 메타 지식을 익힐 수 있게 하는 방법론

- 기계가 스스로 패턴 인식 능력을 개발 👉 inference 단계에서 원하는 task 에 빠르게 적응할 수 있음

- task 가 명시되지 않은 상태에서 다양한 패턴을 인식하는 능력을 학습하여, 처음보는 task 에 대해서도 task description 과 몇 가지 예제만 주면 적절한 답을 생성할 수 있게 된다.

✔ Task

💨 좋은 성능을 보인 task

💨 별로인 성능을 보인 task

✔ 한계점

💨 인터넷 자료들로 학습한 모델이므로 온라인의 수많은 가짜 정보, 편견을 그대로 학습

💨 인간과 같은 일반화 능력은 아직 도달하지 못함

💨 단순히 글로만 언어를 학습함 : merely learning from text without being exposed to other modalities

💨 언어모델을 구동하는데 필요한 엄청난 전력 소비

2️⃣ Compositional representation and systematic generalization

① 용어정리

✔ systematicity

- 사람이 이해하는 문장들 간에는 확실하고 예측 가능한 패턴이 있다.

- EX. 철수는 영희를 좋아한다 → 영희는 철수를 좋아한다 👉 인간의 언어행동은 체계성을 갖추었으므로 앞의 문장을 이해했다면 뒤의 문장도 만들어낼 수 있다.

✔ compositionality

- 한 표현의 의미는 그 표현을 구성하는 구성 요소들의 의미와 구조로 구성된다.

② Compositional

✔ 인간의 언어

- 구성성을 갖춘 경우도 있고 그렇지 않은 경우도 있다.

✔ 신경망 표현

- NN 을 통해 생성한 결과가 구성성을 띄는지 확인하는 방법에 대한 연구

- NN 이 결과로 내놓은 representation 과 , syntax tree 와 composition function 을 따라 결합된 representation 를 근사시키어 구성성을 반영하도록 학습한다.

- 현존하는 모델들이 구성 일반화 능력을 갖추었는지, 이런 능력을 측정하기 위해선 데이터셋을 어떻게 넣어야 하는지에 관한 연구

③ 일반화 능력

✔ Compositional Generalization

◻ 이미 알고있는 요소들로 새로운 조합을 만들거나 만들어진 조합을 이해할 수 있는 능력

✔ 관련 연구

◻ 모델의 구성 일반화 능력을 측정할 수 있는 방법을 제안한 논문

✔ 구성 일반화를 잘 반영하기 위한 데이터셋 분리 방법

◻ Atom distribution 은 유사하면서 compound distribution 은 다르도록 dataset 을 split 하는 것이 가장 이상적임

👉 즉 사용되는 단어는 유사하나, 단어의 조합 형태는 다를수록 구성 일반화를 잘 반영한 것

◻ 구성 일반화 측정 실험

3️⃣ NLP model 의 성능 평가를 개선하는 방식

① 모델의 성능

🙄 벤치마크 데이터셋에서의 성능은 날로 증가하지만, 실제 세계에서의 모델 성능도 그러한가

✔ Dynamic benchmarks

👉 모델이 속을 수 있을만한 어려운 예제들을 추가하여 학습을 진행하도록 함

4️⃣ Grounding language to other modalities

✔ 단순한 텍스트를 넘어 다양한 modality 를 사용해 언어를 이해하는 것

👉 텍스트로만 학습하는 것은 언어가 무엇에 관한 것인지 그것이 어떤 작용을 하는 것인지 알기 어렵다.

✔ Grounds language

'1️⃣ AI•DS > 📗 NLP' 카테고리의 다른 글

| [cs224n] 14강 간단 내용정리 (1) | 2022.07.18 |

|---|---|

| [cs224n] 18강 내용정리 (1) | 2022.07.18 |

| [cs224n] 15강 내용정리 (0) | 2022.07.04 |

| [cs224n] 13강 내용정리 (0) | 2022.07.04 |

| NER 실습 (0) | 2022.06.02 |

댓글