💡 주제 : NLG

📌 핵심

- Task : NLG - Natural language generation

- text summarization

1️⃣ LM and decoding algorithms

① NLG task

✔ NLP = NLU + NLG : 자연어의 의미를 분석해 컴퓨터가 처리할 수 있도록 하는 일

👉 NLU : 자연어를 기계가 이해할 수 있는 형태로 변환하는 NLP 분야

👉 NLG : 시스템 계산 결과를 자연어로 자동 생성하는 NLP 분야

✔ NLG = 새로운 text 를 만들어 내는 모든 task 를 의미한다.

◽ Task : 기계번역, 텍스트 요약, 채팅, 스토리텔링, QA 등이 있다.

✔ 좋은 NLG 기준

◽ 적절성 : 생성된 문장이 모호하지 않고 원래의 input text 와 의미가 일치해야 한다.

◽ 유창성 : 문법이 정확하며 어휘를 적절히 사용해야 한다.

◽ 가독성 : 적절한 지시어, 접속사 등을 사용해 문장의 논리관계를 고려하여 생성한다.

◽ 다양성 : 상황이나 대상에 따라 표현을 다르게 생성한다.

② LM 복습

✔ Language model

◽ 주어진 단어들로부터 다음 단어를 예측하는 모델

✔ Conditional Language model

◽ 주어진 단어들과 어떤 입력 x 으로부터 다음 단어를 예측하는 모델

◽ EX. 기계번역 : x = 번역할 문장, y = 번역된 문장

◽ Ex. Neural Machine Translation (seq2seq)

- 가지고 있는 target sentence (정답 문장) 을 입력으로 넣어주어 학습을 시킨다.

- 주의) 학습 과정에서는 output 이 다음 step 의 input 으로 들어가는 방법이 쓰이지 않음

→ Decoder 의 input 으로 Decoder 를 빠져나온 output 이 아니라 Target sentence 를 그대로 넣어 학습함

③ Decoding algorithm

✔ conditional LM 을 학습 시킨 후, text generation 하는 방법

👉 휴리스틱한 탐색 방법으로 최대한 가능성이 높은 출력 시퀀스를 디코딩하기

🔸 Greedy decoding

◽ 각 step 마다 가장 큰 확률값을 가지는 한 개의 단어를 선택 : argmax

◽ Backtracking 이 부족해 어떤 단계에서 실수가 발생한 경우에, 뒤이은 최종 결과가 좋지 않다. 문법적으로 맞지 않거나 부자연스럽거나 말이 되지 않는 결과가 나올 수도 있다.

🔸 Beam search

◽ 각 step 마다 가장 큰 확률값을 가지는 k 개의 단어를 선택 → negative log 값이 가장 높은 경우를 찾아 나가는 방법

◽ k 가 커질수록 연산량이 높아지고, 문장이 짧아질 수 있어 BLEU 점수가 감소하는 경향이 존재한다.

→ beam size 가 너무 작으면 주제에 더 가깝지만 말이 안되는 답변을 뱉음

→ beam size 가 너무 크면 너무 generic 하고 짧은 답변을 뱉으며 BLUE score 를 떨어트림

✔ Sampling-based decoding

👀 Beam search 에서 큰 k 를 가지더라도 너무 generic 한 결과는 나오지 않도록 하는 방법

🔸 Pure sampling

◽ 각 step 마다 확률 분포 Pt 로부터 랜덤하게 샘플링하는 방식으로 greedy decoding 과 비슷하나 argmax 를 사용하진 않는다.

🔸 Top-n sampling

◽ 각 step 마다 절단된 확률분포 Pt 로부터 랜덤하게 샘플링하는 방식

◽ 완전하게 랜덤 샘플링을 하는 것이 아니라 확률이 가장 큰 n 개의 단어들 중 랜덤 샘플링을 진행한다.

◽ n=1 인 경우 greedy search 와 동일하며 n=v 인 경우에는 pure sampling 에 해당한다.

◽ n 이 커질수록 다양한 하지만 적절하지 않은 문장이 나올 수 있고, n 이 작아질수록 일반적인 평범한 문장이 나오게 된다.

* n 은 사용할 단어 개수

④ Softmax temperature

✔ decoding 알고리즘과 함께 사용되는 기법

◽ timestep t 에서 LM 은 확률분포 Pt 를 softmax 를 이용해 구한다.

◽ Softmax 함수에 temperature hyperparameter τ 를 적용한다.

✔ 확률분포의 다양성을 조절할 수 있는 방법

◽ temperature hyperparameter τ 가 커질수록 Pt 는 Uniform 해짐 → 결과 값이 기존보다 작아짐 → 확률 분포가 균일해진다.

◽ temperature hyperparameter τ 가 작을수록 Pt 는 Spiky 해짐 → 결과 값이 기존보다 커짐 → 확률 분포가 뾰족해진다.

| 방법 | 정리 |

| Greedy decoding | 단순한 방법이나 성능이 좋지 않음 |

| Beam Search | k 가 클수록 다양한 output 이 나오나 적절하지 않음 |

| Sampling method | 다양성과 랜덤성을 부여함 |

| Softmax temperatures | 디코딩 알고리즘은 아니지만 함께 사용되어 다양성을 조절할 수 있는 방법 |

2️⃣ NLG tasks and neural approaches to them

① text summarization

✔ 텍스트 요약

입력 텍스트 x 가 주어지고 x 의 주요 정보를 포함하는 요약 y 를 생성하는 작업

◽ Single-document : 하나의 문서 x 에 대한 하나의 요약 y

◽ Multi-document : 여러 개의 문서 x1,x2,x3,...,xn 에 대한 하나의 요약 y → 여러 개의 문서는 일반적으로 서로 중복되는 내용들의 문서들 (ex. 동일한 이슈에 대한 뉴스기사)

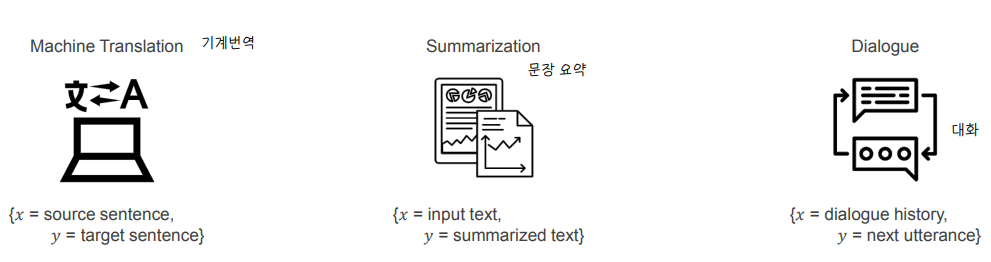

✔ Single document 텍스트 요약에 적합한 데이터셋

◽ Reddit TIFU 데이터셋의 경우, 게시글을 올릴 때 마지막에 요약글을 작성하도록 되어있어 적합함

✔ 2가지 주요 접근법

🔸 Extractive summrization

◽ 텍스트 내에서 원본 글자 그대로 중요한 문장을 추출하는 방법

◽ 원본 글자를 유지하면서 요약하므로 쉽지만, 그만큼 제약적인 부분이 존재한다.

🔸 Abstractive summrization

◽ 원본 텍스트에서 가장 중요한 정보를 내포하는 새로운 문장을 생성하는 방법

◽ 어려운 task 이지만 좀 더 유연한 결과를 도출할 수 있다.

✔ Pre-neural summarization

◽ Neural Network 을 사용하기 이전에는 대부분 extractive summarization 기법으로 텍스트 요약을 진행함

◽ extractive summarization 은 3가지 단계로 구성됨

① Content selection : 문서에서 중요한 문장 (topic 에 해당하는 문장) 을 추출하는 단계

② Information ordering : 추출한 문장에서 중요도에 따라 정렬하는 단계

③ Sentence realization : 요약 문장을 구성하는 단계 (ex. simplify, fix continuity issues)

✔ Pre-neural summarization - content selection

◽ 문장에 대한 점수 계산은 tf-idf 를 이용

◽ Graph-based 알고리즘은 문서 내 문장이 노드가 되고 문장과 문장의 유사한 정도를 엣지로 표현한다.

- PageRank 알고리즘을 기반으로 함

- 문장은 그래프의 노드가 되고 엣지는 문장과 문장 사이의 관계를 나타냄

- 주로 문장은 TF-IDF 를 이용한 Vectorization 방법을 사용해 나타냄

✔ 텍스트 요약 모델 성능 평가지표 : ROUGE

◽ n-gram overlap 을 사용하는 점 (얼만큼 맞았는지에 대해 관심) 에서 BLUE 와 비슷하지만 ‥‥

- BLUE 는 MT 에 ROUGE 는 Summarization 에 주로 사용됨

- ROUGE 는 문장 길이에 대한 과적합 보정 (brevity penalty) 가 없음

- ROUGE 는 recall 에 기반하고 BLUE 는 precision 에 기반한 점수 산출을 계산함

- BLUE 는 n=1,2,3,4 n-gram 의 precision 에 대한 combination 값이지만 ROUGE 는 각 n-gram 에 대한 결과가 따로 나온다.

◽ 자주 사용되는 ROUGE 점수

- ROUGE-1 : Unigram overlap

- ROUGE-2 : bigram overlap

- ROUGE-L : longest common subsequences (LCS) overlap → 단어 순서대로 일치하는 개수 (순서가 중요)

② Neural text summarization

✔ NN 기반 텍스트 요약 모델

◽ 2015년 Ruch 가 처음으로 Seq2Seq based summarization 논문을 냄

◽ single-document 요약 task 는 번역 task 로 간주할 수 있다 → NMT 방법인 seq2seq+attention 을 적용

👉 Seq2seq 와 attention 만 적용한 모델은 디테일을 잡아내기에 한계점이 존재

✔ 이후 발전 형태

◽ copy mechanism 을 사용해 디테일을 잡아냄

◽ attention 구조가 계층적/다층적 구조를 가지게 됨

◽ More global, high level 문장 선택

◽ 요약한 길이를 잘 맞추거나 ROUGE 점수를 높이는 방향으로 학습할 수 있도록 '강화학습' 을 사용

✔ copy mechanism

◽ seq2seq + attention 모델의 decoding 과정에서 발생하는 문제를 해결하기 위한 방법

- 문장 생성 시 OOV 문제

- 고유 명사 (ex. 사람 이름) 들의 출력 확률이 낮아지는 문제

◽ input 문장에서 출력에 필요한 단어나 구문을 복사하는 방법

◽ Copy & generation 👉 hybrid extractive/abstractive approach

- extractive approach와 abstractive appoarch를 모두 고려하여 디테일을 잡아낸다.

✔ Bottom-up summarization

◽ pre-neural summarization 은 중요 문장을 선택하는 부분과 요약하는 부분이 나뉘어저 동작한다.

◽ 그러나 neural approach 는 하나로 묶어져 나오기 때문에 전체적인 것을 보지 못하는 문제점이 존재한다. 따라서 copy 를 더 많이 진행해 extractive 형태가 되어버리는 경우가 많다.

👉 이러한 부분을 보완하기 위해 등장한 방법이 bottom-up summarization 기법이다.

◽ 단어가 포함되었는지 여부에 따라 0과 1을 태깅하여 모델은 단어가 포함되지 않은 부분에는 집중하지 않도록 한다. 간단하지만 매우 효과적인 방법이다.

✔ Pointer-Generator Networks

◽ 2017 년 제안된 abstractive summarization model

◽ seq2seq + attention 이 가지는 문제점

- 부정확하게 문장을 생성

- 특정 단어가 반복되는 문제

👉 이 문제를 해결하기 위해 seq2seq + attention 모델에 개념을 추가

- Source text 에서 단어를 copy 하는 pointer

- 단어를 생성하는 generator

- 단어가 반복 생성되는 것을 막기 위한 coverage

◽ generation probability 인 P_gen 을 통해 timestep t 에서 단어를 copy 할지 생성할지 결정한다.

◽ 최종 p(w) 는 P_vocab 과 attention distribution 의 혼합 형태이다.

✔ Pointer-Generator Networks - Coverage mechanism

◽ 단어가 반복되는 것은 seq2seq 에서 자주 발생하는 문제이다.

◽ 반복 문제를 해결하기 위해 coverage model 을 적용한다.

✔ Pointer-Generator Networks - 실험 결과

◽ Dataset : CNN 뉴스 요약 데이터셋

◽ Model size

◽Training

③ Dialogue

✔ 대화 시스템

◽ Task-oriented dialogue

- Assistive: 고객 서비스, 추천 제공, 질의 응답

- Co-operative: 두 agent가 하나의 태스크를 함께 해결

- Adversarial: 두 agent가 대화를 통해 태스크에서 경쟁

◽ social dialogue

- Chit-chat

- Therapy

◽ Neural dialogue 이전에는 prefined template 기반으로 시스템을 구축하거나 응답 코퍼스에서 검색하는 방식을 사용했다.

◽ 2015년 이후 seq2seq 방식이 도입되며 open-ended freeform 대화 시스템을 만들게 되었다. 그러나 사용자의 발화와 관계없는 반응을 생성하거나, 너무 광범위하거나 비슷한 응답을 생성하거나, 같은 반응을 반복해서 생성하거나, 모델의 페르소나가 일관되지 못하는 등의 문제점이 존재했다.

✔ End to End method

④ Storytelling

✔ sequences of events

◻ 이미지가 주어졌을 때 스토리 생성

◻ 짧은 키워드들이 주여졌을 때 스토리 생성

◻ 현재 시점까지의 스토리가 주어졌을 때 앞으로의 스토리 생성

3️⃣ NLG evaluation, trends , Unpaired corpus

① NLG 평가지표

✔ NLP task 의 평가지표

◽ BLUE, ROUGE, F1 ... → 기계번역에서는 이상적인 지표는 아님 , 텍스트 요약이나 대화 task 에서는 더 적합하지 않음

◽ perplexity : 값이 낮을수록 토픽 모델 학습이 잘 되었다고 평가할 수 있으나, generation 을 평가하진 못한다.

👉 전반적인 NLG 성능을 평가하는 지표는 없음. 사람이 직접 평가하는 것이 가장 이상적인 기준에 가까운 지표이나, 비용과 시간이 너무 오래 걸린다.

② Trends

◽ NMT 방법이 아닌 다양한 NLG 기법들이 생기고 있음

✔ NLG research Tip

③ Unpaired Corpus

◽ 지금까지 배워온 NLP 문제 해결 방법 : Supervised traning

- 입력 정보에 대응하는 출력문장을 준비시켜 학습하는 Paired corpus 기반 학습 방법

- 이러한 데이터를 대량으로 구축하는 것은 굉장히 어려움 👉 Unsupervised traning 에 관한 연구가 진행 중

👀 어떤 스타일의 문장이 들어와도 Latent vector 형태로 인코딩 한다.

👀 인코딩된 Latent vector 가 주어졌을 때 각 스타일에 해당되는 디코더는 해당 스타일의 문장을 생성할 수 있어야 함

👀 위의 내용을 학습하기 위해 인공 신경망은 Autoencoder loss, Cycle loss 를 최소화하는 방향으로 학습하게 된다.

④ PORORO

'1️⃣ AI•DS > 📗 NLP' 카테고리의 다른 글

| [cs224n] Future NLP (2021 version) (0) | 2022.07.18 |

|---|---|

| [cs224n] 18강 내용정리 (0) | 2022.07.18 |

| [cs224n] 13강 내용정리 (0) | 2022.07.04 |

| NER 실습 (0) | 2022.06.02 |

| Glove 실습 (0) | 2022.05.31 |

댓글