📌 교내 '인공지능' 수업을 통해 공부한 내용을 정리한 것입니다.

Recap

✨ RNN, LSTM

◾ RNN → gradient vanishing problem → LSTM

1️⃣ NLP

① Natural language processing

◼ NLP : 컴퓨터로 인간의 언어를 사용하는 것

◼ Natural language

◼ example

💨 machine translation

💨 Sentiment classification

💨 Spam filtering

💨 Chat-bot

👉 많은 NLP 응용은 language model 을 기반으로 하고 있다.

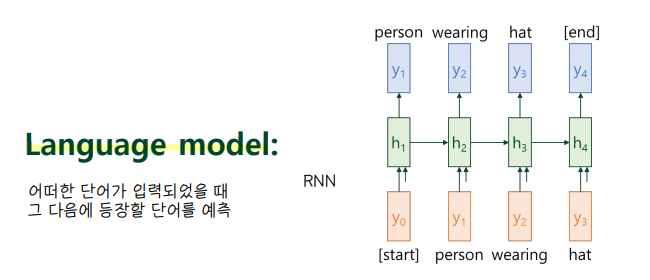

② Language model

(1) language model

◼ 연속된 단어에 대한 확률분포를 할당하여 언어 모델을 생성한다.

◼ 일련의 단어 배열이 있을 때 그 다음에 올 단어를 예측

→ 가장 확률이 높은 단어 w5 를 그 다음에 올 단어로 예측한다.

(2) How to represent words in Numbers

🤔 단어를 input 으로 넣을 때 어떤 숫자 형태로 넣어주어야 하는가

💨 One-hot vector (Sparse representation)

- 단어 사전을 정의한다 : vocabularly 👉 각 단어마다 순서에 대한 index 를 부여

- vocab size 만큼의 크기를 가진 벡터에서 해당 단어가 위치한 곳에서만 값이 1인 원핫 벡터를 생성

◾ 원핫벡터 표현의 문제점

- 가능한 단어 수를 생각하면 벡터 사이즈가 너무 커진다 → NN input 으로 쓰기 어려움

- 0과 1의 숫자로만 이루어진 값이므로 연관성 있는 단어 관계를 반영하기 어렵다. ex) Queen-Woman

💨 Embedding vector (Dense representation)

- 단어의 연관성을 고려하여 숫자로 표현한 방법

- 단어간 유사성을 표현할 수 있는 대표 특징 (ex. Gender, Age.....) 들을 소수점 숫자로 표현할 수 있게 하면서 벡터의 크기를 고정되게 만듦

- 벡터 크기를 300으로 고정시킨다면, 크기가 300인 벡터에 숫자 값이 존재하게 된다.

- 벡터를 생성하는 과정은 feature extraction 으로 볼 수 있으며, 위의 예제와 같은 특성들을 기계가 학습을 통해 도출해낸다.

2️⃣ Word Embedding

① Embedding table

◼ One-hot vector → (feature extraction) → Embeeding vector

- embeding table 이 주어졌을 때 원핫벡터와 곱해지는 과정을 통해 특정 단어에 대한 임베딩 벡터를 생성한다

- 임베딩 테이블에서 특정 단어와 대응되는 인덱스 칼럼을 불러오는 과정으로 임베딩 벡터를 생성하기 때문에 embedding lookup 이라고도 부른다.

⭐ embedding table 값은 기계 '학습'을 통해서 얻는다. (ex. Word2Vec)

② Word2Vec

⭐ embedding vector 를 도출하는 방법

⭐ key Idea : Distributional Hypothesis → 같이 반복해서 등장한 단어일수록 유사도가 높을 것이라는 가정

(1) CBOW

◼ window size 만큼의 주변 단어를 바탕으로 중심 단어를 예측하는 방식으로 embedding table 을 도출한다. (일종의 지도학습 방법)

◼ input : 주변 단어의 원핫벡터 (차원 |v| : vocab size) 들

💨 input vector x W :각 input vector 에 대해 가중치를 곱하여 구한 벡터 V 에 대해 평균을 내려 M 벡터를 도출한다.

💨 output vector = M x W' : embedding vector M 과 또 다른 가중치 행렬 W' 값을 곱하여 중심 단어 벡터를 예측한다.

◼ output : 중심 단어의 원핫벡터

👉 2개의 weight matrix 가 학습 과정에서 도출되는데, 보통 2개의 W matrix 를 평균하거나 둘 중 하나를 선택한 것이 embedding table 이 된다.

(2) Skip-gram

◼ 주변 window 만큼의 단어를 중심 단어를 통해 예측한다.

◼ input : 중심 단어의 원핫벡터, output : 주변 단어의 원핫벡터

◼ softmax 결과와 Ground truth 결과 사이의 오차를 계산하여 도출한 gradient 로 embedding table 의 embedding vector 에 대해 업데이트를 수행한다.

💨 Negative sampling

- 단어의 개수가 많은 경우 embedding table 의 차원이 증가하므로 값을 모두 업데이트 하는 데 있어 cost 가 증가하기 때문에 이를 줄이기 위해 negative sampling 을 진행한다.

- window size 에 해당되지 않는 단어들은 관련성이 적을 것이라는 판단 아래에, 그에 해당되는 임베딩 벡터를 업데이트 하는 것은 비효율적이므로, 윈도우 사이즈 외에 있는 임베딩 벡터 중 랜덤하게 뽑은 샘플들에 대해서 임베딩 벡터의 업데이트를 수행

- positive sample : 윈도우 크기에 해당되는 벡터

- negative sample : 랜덤하게 뽑은 단어 벡터

- positive, negative label 의 classification 문제가 된다.

◼ 적은 개수의 input 에 비해 update 되는 부분이 많기 때문에 (적은 개수의 input 으로 많은 output 을 예측하는 꼴) CBOW 보다 성능이 좋아 skip-gram 방식이 많이 사용된다.

(3) Property of Word Embedding

◼ language model 에서 분포 가정에 기반한 word embedding 방법은 굉장히 중요하다.

◼ 다른 단어의 유사도를 통해 새로운 단어를 예측할 수 있다 → language model 에 적절한 표현방식

③ Pretrained Word embedding

◼ word embedding 에 필요한 embedding table 을 훈련하는 것은, 단어가 많을수록 행렬 차원이 매우 크기 때문에 꽤나 시간이 오래걸린다.

◼ 따라서 미리 만들어놓은 embedding table , "pre-trained word embedding" 을 사용한다.

◼ Transfer learning : 미리 생성한 embedding table을 사용하는 것

3️⃣ Machine Translation

① Conditional Language model : Translation

◼ language model : 어떠한 단어가 입력되었을 때 그 다음에 등장할 단어를 예측

◼ machine translation (Seq2Seq) : conditional language model 로 어떠한 문장이 주어졌을 때 (조건부) 그에 걸맞는 번역된 단어가 등장할 확률을 모델링 하는 task 이다.

② 가장 좋은 번역 결과 찾기

(1) Probability

◼ 가장 좋은 번역 결과를 얻기 위해선 가장 확률이 높은 단어의 조합을 찾는다.

(2) Greedy Search

◼ 각 step 별로 가장 높은 확률을 가진 output 을 내는 방법 (huristic method)

- 각 step 별로 1만번씩 search 를 하여 가장 높은 확률에 해당하는 단어를 도출하는 방법으로, 속도가 빠르지만 greedy 하게 탐색하는 방법이기 때문에 최고의 결론은 아닐 수 있다. 즉, 실제 얻고자 했던 번역 결과에 잘 맞지 않는 결과가 도출 될 수도 있다.

(3) Beam Search

◼ greedy search 단점을 보완하여 등장한 탐색 방법으로, greedy search 는 각 step 에서 가장 큰 확률 값을 가진 하나의 값만 고려했다면 beam search 에서는 가장 높은 확률을 k 개 가져온다.

◼ greedy searh 보단 좀 더 많은 경우의 수를 고려하므로 번역의 질이 올라간다.

◼ k = beam size

→ k=2 이면 각 step 마다 가장 높은 확률 결과를 2개씩 도출해낸다.

③ Evaluation

⭐ 번역의 질을 정량적으로 측정(평가) 하는 방법

🤔 기계가 번역한 결과 문장과 사람이 번역한 G.T 문장 결과의 유사도를 어떻게 정량적으로 측정할 수 있을까

(1) Unigram precision

◼ 기계번역된 문장에서 특정 단어가 정답 reference 후보 문장에서 등장했는지 여부를 세어본다.

⭐ unigram precision = (reference 문장들에 존재하는 후보 문장 단어의 개수) / (후보 문장에 본재하는 총 단어 개수)

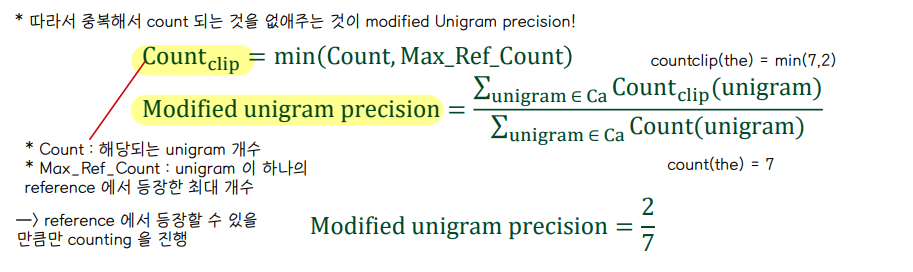

(2) Modified Unigram precision

◼ unigram precision 의 치명적인 단점

◼ 따라서 중복해서 count 되는 것을 없애주는 방법으로 modified unigram precision 방법이 등장했다.

⭐ Count_clip = min(Count, Max_Ref_Count)

- Count : 해당되는 unigram 개수 👉 candidate 문장에서 등장한 the 의 개수는 7

- Max_Ref_Count : unigram 이 하나의 reference 에 등장한 최대 개수 👉 reference1 에 'the' 라는 단어가 2번, reference2 에서는 1번 등장했으므로 최대 2번 등장

- Count_clip(the) = min(7,2) = 2

⭐ modified unigram precision = Sum (Count_clip(unigram)) / Sum(Count(unigram))

- candidate 문장의 각 (중복되지 않는 고유의) 단어 unigram 별로, Count_clip 를 구해서 모두 더한 값과, Count 를 구해서 더한 값을 나누어 주면 됨 ❗❗ 주의 ❗❗

- 해당 Candidate 문장에는 구분되는 unigram 단어가 'the' 뿐이므로 Count_clip(the) / Count(the) 를 계산하면 됨

- Count(the) 는 candidate 문장 내에 the 가 7번 등장하므로 7 이고 Count_clip(the) 는 위에서 구한 2이므로 2/7이 정답

(3) Modified n-gram precision

◼ Unigram 만 보면 단어의 순서가 전혀 고려되지 않기 때문에 N-gram precision 방식을 사용한다.

⭐ 꼭 손으로 직접 계산해볼것!

(4) BLEU

◼ bilingual evaluation understudy

◼ 기계번역의 정량적 질을 판단할 수 있는 metric

◼ Wn : n-gram precision 별로 다르게 가중치를 부여한다. 만약 N=4 라면 unigram, biagram, trigram 4-gram 별로 각각 w1, w2, w3, w4 의 가중치를 부여한다. 이때 가중치들의 총합은 1이 되도록 한다.

◼ Pn : modified n-gram score

◼ BP : 문장 길이에 대한 패널티 값으로, 문장 길이가 짧은 경우 패널티를 부여한다.

- 기계번역의 결과가 짧을수록 n-gram precision 이 높아지는 경향성이 있다.

- 만약 후보문장의 길이가 참조문장의 길이보다 길면 BP=1 로 패널티가 없고

- 후보문장의 길이가 참조문장의 길이보다 짧으면 점수에 대한 패널티를 e^(r/c) 만큼 부여한다.

- c : candidate 문장의 길이, r : reference 문장의 길이

'1️⃣ AI•DS > 📒 딥러닝' 카테고리의 다른 글

| [인공지능] GAN (0) | 2022.06.13 |

|---|---|

| [인공지능] Transformer Models (0) | 2022.06.11 |

| [인공지능] RNN (0) | 2022.06.07 |

| [인공지능] Regularization (0) | 2022.04.26 |

| [인공지능] 다양한 CNN 모델 (0) | 2022.04.26 |

댓글