👀 인과추론 개인 공부용 포스트 글입니다. 출처는 첨부한 링크를 참고해주세요!

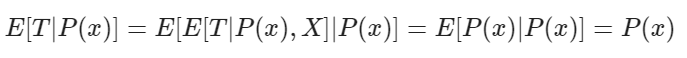

※ 정리 1

※ 정리 2

📜 정리

• 성향점수 = Treatment 를 받을 확률

• 성향점수가 있다면 Confounder 를 직접 제어할 필요가 없으며, 성향점수를 통제하는 것만으로 충분하다.

① Example

◯ 주제

• 학생들이 학교에서 성장 마인드셋에 대한 세미나를 참여하고 교육을 받은 학생들이 학업적으로 어떠한 성취가 있었는지 측정하기 위해 세미나 수업을 받은 학생들의 대학생활을 추적한다.

◯ 데이터셋

• school_achievement : 표준화된 성취도 (표준화 됨 = 변수가 표준편차로 측정됨)

• success_expect : 자기개발 성공 기대도 (미래 성공에 대한 자체 기대 평가) → 무작위 할당 이전에 측정된 선행 성과에 대한 proxy 변수로 활용

• intervention : 세미나 수업 참가 여부

• 무작위 연구이긴 하나, 참여의 기회는 무작위로 이루어졌음에도 참여 자체는 그렇지 않을 수 있다. 자기계발 성공 기대도가 높은 학생들은 성장 마인드 세미나에 참여할 가능성이 높기 때문이다. 아래와 같이 성공 기대도 별 평균 세미나 참석률을 확인해보면 기대도가 높을 수록 참여율이 올라가는 것을 데이터로도 확인해 볼 수 있다 ⇨ 편향이 Positive

data.groupby("success_expect")["intervention"].mean()

◯ 처치효과

• 회귀분석을 통해 E[Y(0) | T=1] 과 E[Y(0) | T=0] 의 값이 어떻게 차이 나는지 확인해보자

smf.ols("achievement_score ~ intervention", data=data).fit().summary().tables[1]

• 개입이 있는 경우와 없는 경우를 단순히 비교하면 Treatment 를 받는 사람의 성취도 점수가 평균보다 0.3185 높음을 알 수 있다 (0.4723 - 0.1538)

• 표준화된 변수이기 때문에 Treatment 를 받은 그룹은 받지 않은 그룹보다 0.3185만큼 표준편차가 크다고 해석해 볼 수 있다.

② Propensity score

◯ 성향 점수

• Confounder X 들에 대해 직접적으로 제어하지 않아도 조건부 독립을 달성할 수 있다는 아이디어에서 시작

↪ (Y1, Y0) ⊥ T | X

• 성향점수 : Treatment 의 조건부 확률 P(T|X) 이다. P(x) 로 기입하기도 한다.

• 성향점수를 활용하면 Treatment 에 대한 잠재적 결과로부터 독립성을 얻기 위해 Confounder X 전체를 조건화 할 필요가 없다. 성향점수 하나만 제어하는 것으로도 충분하다.

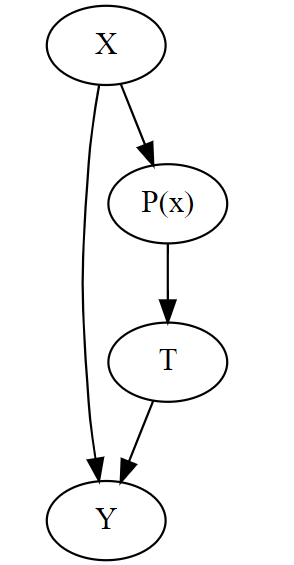

• 변수 X를 Treatment T 로 변환하는 일종의 함수라고 생각할 수 있다. 즉, 성향점수는 X와 Treatment T 사이의 중간 지점을 만든다.

• Treatment 를 받은 그룹과 받지 않은 Control 그룹에서 각각 한 명씩 Treatment 를 받을 확률을 같도록 선택한다면 비교 가능해진다. 만약 두 명의 Treatment를 받을 확률이 정확하게 같다면, 그들 중 1명은 Treatment를 받고 나머지 한 명이 Treatment를 받지 못한 유일한 이유는 우연으로 발생한 결과이다. (무작위 조건 성립)

◯ 수학적 해석

• P(x) = E[T|X]

• (Y1, Y0) ⊥ T | P(x) 가 E[T | P(x),X] = E[Y | P(x)] 인지 보이면 된다.

• P(x) 를 조건으로 두면 X가 T에 대한 추가적인 정보를 줄 수 없음을 의미한다.

③ Propensity weighting

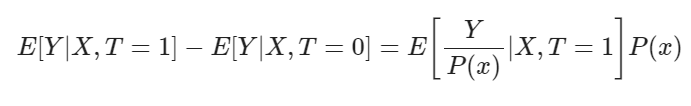

◯ IPTW

• Treatment를 받은 모든 사람을 Treatment의 역확률로 측정하여 Treatment를 받을 가능성이 매우 낮은 사람들에게 높은 가중치를 주는 방법

※ treatment를 받을 확률이 작은 그룹에는 더 많은 weight을 주어서 확률을 더 키우고, treatment를 받을 확률이 큰 그룹에는 weight를 작게 주어서 확률을 낮춘다. treatment를 받을 확률을 비슷하게 만들어 주겠다는 게 weighting 방법이다.

• 파란색 점 : Treatment 를 받지 않는 그룹, 빨간색 점 : Treatment 를 받은 그룹

• 왼쪽 하단 그래프 : P(x) 성향점수

• IPTW 적용 이후 그래프를 보면 빨간색이 더 높은 가중치를 받았음을 확인해 볼 수 있다.

④ Propensity score estimation

◯ 성향점수 추정

• 성향점수를 추정할 때, 일반적인 방법은 로지스틱 회귀를 활용하는 것이지만, 그래디언트 부스팅과 같은 다른 기계학습 방법을 활용할 수도 있다.

• 로지스틱 회귀를 사용할 때는 데이터 세트의 범주형 변수를 더미로 변환해야 한다.

categ = ["ethnicity", "gender", "school_urbanicity"]

cont = ["school_mindset", "school_achievement", "school_ethnic_minority", "school_poverty", "school_size"]

data_with_categ = pd.concat([

data.drop(columns=categ), # dataset without the categorical features

pd.get_dummies(data[categ], columns=categ, drop_first=False)# categorical features converted to dummies

], axis=1)

print(data_with_categ.shape)

# (10391, 32)

• 로지스틱 회귀를 사용해 성향점수를 추정해보면 아래와 같다.

from sklearn.linear_model import LogisticRegression

T = 'intervention'

Y = 'achievement_score'

X = data_with_categ.columns.drop(['schoolid', T, Y])

ps_model = LogisticRegression(C=1e6).fit(data_with_categ[X], data_with_categ[T])

data_ps = data.assign(propensity_score=ps_model.predict_proba(data_with_categ[X])[:, 1])

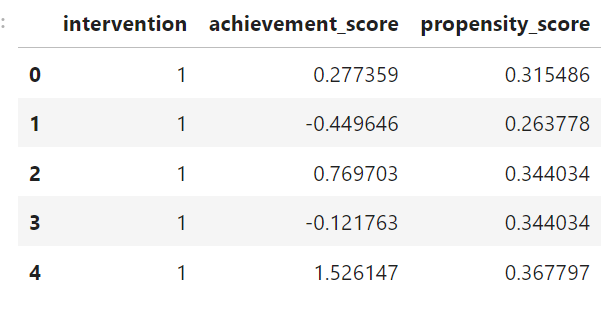

data_ps[["intervention", "achievement_score", "propensity_score"]].head()

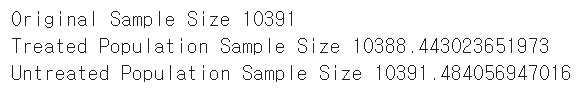

• 가중치를 생성하여 Treated/Untreated sample size 를 확인할 수 있다.

weight_t = 1/data_ps.query("intervention==1")["propensity_score"]

weight_nt = 1/(1-data_ps.query("intervention==0")["propensity_score"])

print("Original Sample Size", data.shape[0])

print("Treated Population Sample Size", sum(weight_t))

print("Untreated Population Sample Size", sum(weight_nt))

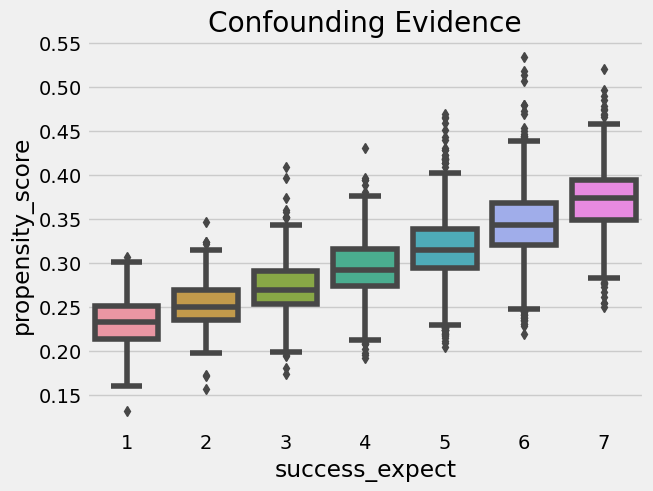

• 또한 성향점수를 사용해 Confounder 의 증거를 찾을 수 있다. 모집단의 세분화가 다른 것보다 성향 점수가 더 높다면 무작위가 아닌 것이 Treatment를 유발하고 있음을 의미한다.

sns.boxplot(x="success_expect", y="propensity_score", data=data_ps)

plt.title("Confounding Evidence");

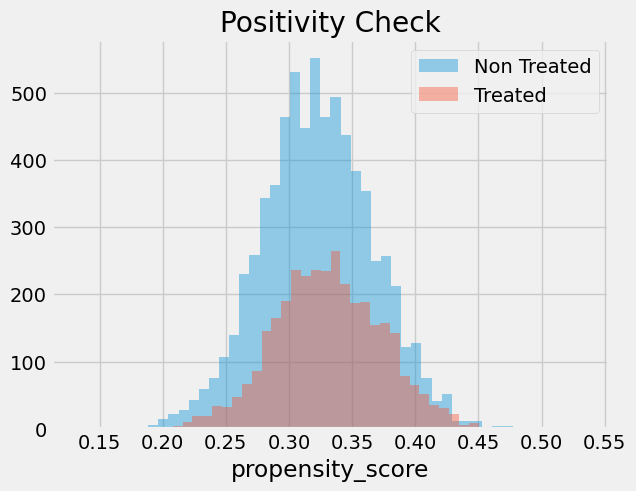

• Treatment를 받은 그룹와 Treatment를 받지 않은 그룹 사이에 중복이 있는지 확인하기 위해 성향 점수의 실증적 분포를 확인해 볼 수 있다.

sns.distplot(data_ps.query("intervention==0")["propensity_score"], kde=False, label="Non Treated")

sns.distplot(data_ps.query("intervention==1")["propensity_score"], kde=False, label="Treated")

plt.title("Positivity Check")

plt.legend();

↪ Treatment 가 균형적으로 처리되었음을 확인

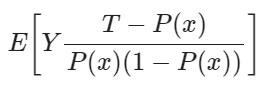

• ATE 추정

weight = ((data_ps["intervention"]-data_ps["propensity_score"]) /

(data_ps["propensity_score"]*(1-data_ps["propensity_score"])))

y1 = sum(data_ps.query("intervention==1")["achievement_score"]*weight_t) / len(data)

y0 = sum(data_ps.query("intervention==0")["achievement_score"]*weight_nt) / len(data)

ate = np.mean(weight * data_ps["achievement_score"])

print("Y1:", y1)

print("Y0:", y0)

print("ATE", np.mean(weight * data_ps["achievement_score"]))

↪ Treatment 받은 개인이 Treatment를 받지 않은 동료보다 성취도 면에서 0.38 표준 편차가 될 것으로 기대해야 한다.

↪ 아무도 Treatment를 받지 않은 경우 일반적인 성취 수준이 현재보다 0.12 표준 편차 낮을 것으로 예상해야 함

↪ 맨 처음 얻은 0.47 과 비교하면 X를 통제하는 것이 보다 Robust 한 결과임을 확인해 볼 수 있다.

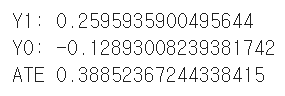

• P(x) 추정 과정의 error 를 설명하기 위해 부스트트랩을 사용하여 ATE 추정값의 분포를 아래와 같이 제시해 볼 수도 있다.

⑤ Propensity score 의 일반적인 문제

• 성향 점수 추정을 하는 데 있어 정확도를 높이려고 할 수도 있다. 그러나 사실, 성향 점수의 예측력을 최대화하면 인과 추론 목표가 손상될 수도 있다. 성향 점수는 Treatment의 확률을 잘 예측할 필요가 없다. 단지 모든 confounder 변수를 포함하기만 하면 된다.

• Treatment를 예측하는 방식이 아니라 Confounder를 제어하는 방식으로 예측을 구성해야 한다. Treatment 확률을 예측하는데 아무런 영향을 미치지 않는 변수를 포함하면 추정값의 분산이 증가한다.

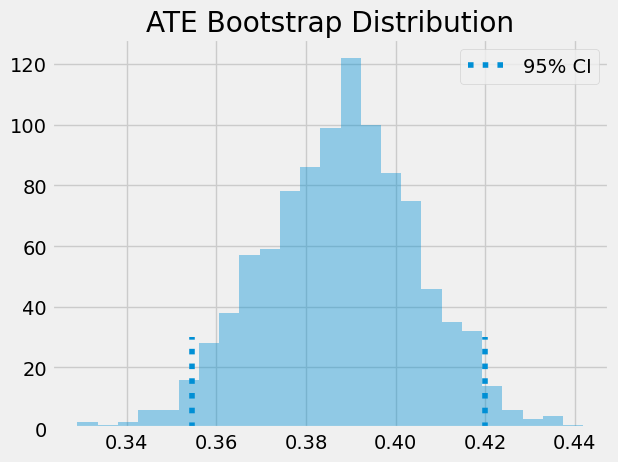

• 성향 점수가 있을 때 X를 통제할 필요가 없다. 성향 점수는 특징 공간에 대한 일종의 차원 축소를 수행하는 것으로 생각할 수 있다. 이러한 이유로 성향 점수를 다른 모델의 입력 기능으로 취급할 수 있는데, 회귀모델을 돌린 예시를 살펴보면

smf.ols("achievement_score ~ intervention + propensity_score", data=data_ps).fit().summary().tables[1]

이전에 얻은 0.47보다 낮게 ATE 를 0.39로 추정함을 확인해 볼 수 있다.

'1️⃣ AI•DS > 🥎 Casual inference' 카테고리의 다른 글

| [The Brave and True] 13. Difference-in-Differences (0) | 2023.07.20 |

|---|---|

| [The Brave and True] 12. Doubly Robust Estimation (0) | 2023.07.14 |

| [The Brave and True] 10. Matching (0) | 2023.07.11 |

| [The Brave and True] 9. Non Compliance and LATE (0) | 2023.07.04 |

| [The Brave and True] 8. Instrumental variables (0) | 2023.07.03 |

댓글