👀 위키독스 : https://wikidocs.net/35476 의 딥러닝 개요 파트 공부한 것 정리 (이미지 출처는 모두 위키독스 홈페이지)

📌 소프트맥스 회귀

- 로지스틱회귀 : 이진 분류 문제 VS 소프트맥스 회귀 : 다중 클래스 분류 문제

- 대표적인 다중 클래스 분류 예제 : iris 붓꽃 품종 분류 (k=3)

- Softmax function

- 클래스의 개수가 k 개일 때, k 차원의 벡터를 입력받아 각 클래스에 대한 확률을 추정한다.

- zi : k차원의 벡터에서 i 번째 원소

- pi : i 번째 클래스가 정답일 확률

k 차원의 벡터를 입력 → 벡터 원소 값을 0과 1 사이의 값으로 변경 → 다시 k 차원의 벡터를 반환

👀 샘플 데이터 벡터(4차원) 을 소프트맥스 함수의 입력벡터 3차원으로 축소하는 방법?

👉 가중치 곱을 진행 : 오차를 최소화하는 가중치 값으로 update 하면서

👀 오차?

👉 오차 = (예측값 - 실제값) 의 차이

👉 실제값의 표현 : 원핫인코딩 벡터

➕ 정수인코딩이 아닌 원핫 인코딩을 사용하는 이유 : 원-핫 인코딩은 분류 문제 모든 클래스 간의 관계를 균등하게 분배 → 오차도 균등하게 계산됨. BUT 원핫인코딩은 각 클래스를 무작위성 관계로 만들기 때문에 단어의 '유사성'은 구하기 어렵다는 단점이 존재

👀 오차 계산 방법?

👉 비용함수로 크로스 엔트로피 함수를 사용

👀 크로스 엔트로피 함수?

º y : 실제값, k : 클래스의 개수

º yj : 실제값 원-핫 벡터의 j번째 인덱스

º pj : 샘플 데이터가 j 번째 클래스일 확률

º cost 를 최소화하는 방향으로 학습한다.

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# iris 붓꽃 품종 예제 : 3개 class, 4개 feautures

model = Sequential()

model.add(Dense(3, input_dim=4, activation='softmax'))

# 입력 차원 = 4, 출력 차원 = 3, 활성화 함수 = 소프트맥스 함수

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 오차함수 = 크로스엔트로피 함수

# 최적화 = 경사하강법의 일종인 adam 을 사용

history = model.fit(X_train, y_train, epochs=200, batch_size=1, validation_data=(X_test, y_test))

# 전체 데이터에 대한 훈련 횟수 : epoch = 200

print("\n 테스트 정확도: %.4f" % (model.evaluate(X_test, y_test)[1]))

# 테스트 정확도: 0.9667

📌 퍼셉트론

- 다수의 입력으로부터 하나의 결과를 내보내는 알고리즘

- 가중치의 값이 크면 클수록 해당 입력값이 중요하다는 것을 의미한다.

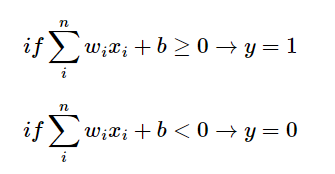

- 각 입력값이 가중치와 곱해져 뉴런에 전송 → 각 입력값과 그에 해당되는 가중치의 곱의 전체 합이 임계치(threshold)를 넘으면 출력 신호로서 1을 출력하고, 그렇지 않을 경우에는 0을 출력 👉 계단함수 (활성화 함수)

- 임계치를 좌변으로 넘겨서 편향 b 로 표현한다. 편향 b 또한 딥러닝이 최적의 값을 찾아야할 변수 중 하나이다.

- 활성화 함수 : 뉴런에서 출력값을 변경 시키는 함수 (계단함수, 시그모이드 함수, 소프트맥스 함수 등)

1. 단층 퍼셉트론

- XOR 문제 : 서로 다른 값일 때만 1, 같은 값을 가지면 0의 출력값을 가지는 XOR 게이트에서, 직선 하나로 하얀색 원과 검은색 원을 나누는 것이 불가능하다는 문제.

2. 다층 퍼셉트론 MLP

- 중간에 층 (은닉층) 을 더 추가한 퍼셉트론 모델

- 아래와 같이 은닉층이 2개 이상인 신경망을 심층 신경망 DNN 이라고 한다.

⭐ 딥러닝 키워드 : 훈련(training), 손실함수(Loss function), 옵티마이저(Optimizer)

📌 인공신경망

1. 피드 포워드 신경망 FFNN

- 오직 입력층에서 출력층 방향으로 연산이 전개되는 신경망

- ↔ 순환 신경망 RNN : 은닉층, 출력층 사이의 방향성이 자유로운 신경망 모델

2. 전결합층 (Fully-connected layer, FC, Dense Layer)

- 어떤 층의 모든 뉴런이 이전 층의 모든 뉴런과 연결돼 있는 층으로 FC 혹은 Dense layer 라고 부른다.

- 케라스에서는 밀집층을 구현할 때 Dense() 함수를 사용한다.

3. 활성화 함수 (Activation Function)

- 은닉층과 출력층의 뉴런에서 출력값을 결정하는 함수

- 활성화 함수의 특징 : 비선형 함수

- 선형 함수 : 출력이 입력의 상수배만큼 변하는 함수로 직선형태를 띈다.

- 비선형 함수 : 직선 1개로 그릴 수 없는 함수. 인공신경망에서는 은닉층을 쌓아야되기 때문에 활성화함수는 반드시 비선형함수여야 한다. 선형함수를 사용하면 아무리 층을 깊게 하더라도 결론적으로 선형(1층)이 되기 때문이다. 선형 활성화 함수를 여러겹 겹처도 표현할 수 있는 정보는 '선형정보' 뿐이다.

(1) 계단함수

- 거의 사용되지 않지만 인공신경망을 처음 배울때 접하게 되는 활성화 함수

(2) 시그모이드 함수

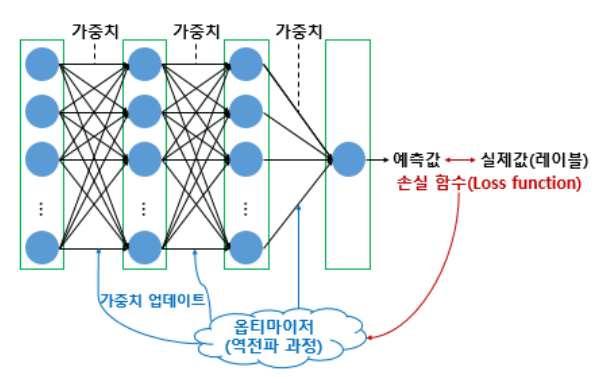

⭐ 인공신경망 학습 과정

- 순전파(forward propagation) 연산을 통해 예측값 계산 → 오차 (예측값 - 실제값) 를 손실함수로 계산 → 손실(오차)의 미분을 통해 기울기(gradient) 를 구함 → 역전파(backpropagation) 수행 : 출력층에서 입력층 방향으로 가중치와 편향을 업데이트 by 경사하강법

👀 시그모이드의 문제는 기울기를 구할 때 발생

- 시그모이드 함수를 미분했을 때 도출 가능한 미분 값은 양 끝단에서 최솟값으로 0, 최대값으로 0.25가 나온다. 즉, 0.25이하의 값이 미분값으로 도출되기 때문에 시그모이드 함수를 활성화함수로 하여 계속 층을 쌓으면 가중치와 편향 업데이트 과정 (역전파 과정) 에서 0에 가까운 값이 누적해서 곱해지게 되므로 앞단에 위치한 노드에는 기울기(미분값) 가 잘 전달되지 않게 된다 👉 기울기 소실 문제

- 위와 같은 문제점으로 인해 시그모이드 함수의 은닉층에서의 사용은 지양된다. 주로 이진분류를 위해 '출력층'에서만 사용된다.

(3) 하이퍼볼릭탄젠트 함수

- 입력값을 -1과 1 사이의 값으로 변환하는 함수

- 이 역시도 -1과 1에 가까운 출력값이 나올때 미분 과정에서 소실 문제가 발생하긴 하나, 미분의 최대값은 1로, 0.25보다는 크다. 전반적으로 시그모이드 함수보단 큰 미분값이 나오므로 기울기 소실이 적은 편이며, 은닉층에서 시그모이드 함수보다는 선호되는 함수이다.

(4) 렐루 함수

- 인공신경망의 은닉층에서 가장 인기있는 함수!

- 음수를 입력하면 0을 출력하고 양수를 입력하면 입력값을 그대로 반환한다. 출력값이 특정 양수 값에 수렴하지 않는다. 0 이상의 입력값의 경우에는 미분 값이 항상 1이기 때문에, 깊은 신경망의 은닉층에서 훨씬 더 잘 작동한다.

- 연산속도도 빠르다.

- 문제점 : 입력값이 음수면 미분값도 0 이 되는 것과, 값이 음수인 뉴런을 다시 회생하는 것이 어렵다 (dying ReLU)

(5) 리키 렐루

- dying ReLU 문제를 보완하기 위해 등장한 변형함수

- 입력값이 음수일 경우에 0이 아니라 0.001과 같은 매우 작은 수를 반환하도록 설계

(6) 소프트맥스 함수

- 출력층에서 자주 사용되는 함수 (은닉층에서는 별로 쓰이지 않음) 로 다중 클래스 분류 문제에 사용한다.

4. 행렬곱 연산

- 인공신경망에 행렬곱을 사용하면 병렬 연산도 가능하다.

👉 인공 신경망의 4개의 샘플을 동시에 처리하고 있지만 학습 가능한 매개변수의 수는 여전히 8개라는점!

이렇게 다수의 샘플을 동시에 처리하는 것을 '배치 연산' 이라고 부른다.

위의 인공신경망을 코드로 구현하면 아래와 같다.

입력층 : 4개의 입력과 8개의 출력

은닉층1 : 8개의 입력과 8개의 출력

은닉층2 : 8개의 입력과 3개의 출력

출력층 : 3개의 입력과 3개의 출력

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

model = Sequential()

# 4개의 입력과 8개의 출력

model.add(Dense(8, input_dim=4, activation='relu'))

# 이어서 8개의 출력

model.add(Dense(8, activation='relu'))

# 이어서 3개의 출력

model.add(Dense(3, activation='softmax'))

📌 딥러닝 학습 방법 - 역전파 이해하기

⭐ 딥러닝 학습 키포인트 : 손실함수, 옵티마이저, 에포크

1. 손실함수

- 실제값과 예측값의 차이 (= 오차) 를 수치화해주는 함수

- 오차와 손실함수의 값은 비례관계

- 회귀는 MSE, 분류는 크로스 엔트로피를 손실함수로 (주로) 사용한다.

# 1.(회귀) MSE

model.compile(optimizer='adam', loss='mse', metrics=['mse'])

# 2.(분류) Binary Cross-Entropy

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['acc'])

# 3.(분류) Categorical cross entropy

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['acc'])

# 4. (분류) 원핫인코딩이 아닌 정수 인코딩으로 분류 수행하고자 한다면

model.compile(loss='sparse_categorical_crossentropy', optimizer='adam', metrics=['acc'])

2. 경사하강법 _ batch size

- 옵티마이저 : 최적화 알고리즘. 최적화란 손실함수의 최소값을 찾아가는 것을 의미한다.

- 배치 : 매개 변수의 값을 조정하기 위해 사용하는 데이터의 양. 전체를 가지고 조정할 수도 있고, 데이터의 일부만 가지고 매개변수를 조정할 수도 있다.

- 경사하강법은 옵티마이저 방법 중 하나로, 배치 경사 하강법, SGD, Mini-batch GD 의 세부 방법으로 나뉜다.

(1) 배치 경사 하강법

- 오차 loss 를 구할 때 전체 데이터를 고려한다. 1 epoch (한 번의 훈련에) 에 모든 매개변수 업데이트를 수행한다.

- 전체 데이터를 고려하므로 시간이 오래걸리며 메모리를 크게 요구한다는 것이 단점

model.fit(X_train, y_train, batch_size=len(X_train))

(2) SGD : 배치 크기가 1인 GD

- 매개변수 조정시 전체 데이터가 아닌 랜덤으로 선택한 하나의 데이터에 대해서만 계산하여 반영

- 빠른 속도 , but 변경 폭이 불안정 (정확도가 낮을 수 있음)

model.fit(X_train, y_train, batch_size=1)

(3) 미니배치 경사 하강법

- 전체 데이터나 1개의 데이터 말고, 특정한 배치 크기를 정해서 해당 데이터 개수만큼에 대해 계산을 진행하여 매개변수의 값을 조정하는 경사하강법

- 빠른 속도, SGD 보다 안정적

- 보통 배치 크기는 2의 n제곱에 해당하는 숫자로 선택하는 것이 보편적

model.fit(X_train, y_train, batch_size=128)

3. 옵티마이저

(1) Momentum

- 경사 하강법에서 계산된 접선의 기울기에 한 시점 전의 접선의 기울기값을 일정한 비율만큼 반영하는 방법으로 이를 경사하강법에 '관성' 을 더해준다고 표현한다. ( = gradient가 0이 되게 하지 않는다 )

- 🧐 관성을 더해준다? : 로컬 미니멈에 도달하였을 때 글로벌 미니멈으로 잘못 인식하여 탈출하지 못하였을 상황에서 모멘텀. 즉, 관성의 힘을 빌리면 값이 조절되면서 현재의 로컬 미니멈에서 탈출하고 글로벌 미니멈 내지는 더 낮은 로컬 미니멈으로 갈 수 있는 효과를 얻을 수 있는 것을 의미한다.

tf.keras.optimizers.SGD(lr=0.01, momentum=0.9)

(2) Adagrad

- 각 매개변수에 서로 다른 학습률을 적용시키는 것

- 변화가 많은 (업데이트 빈도수가 많은) 매개변수는 학습률이 작게 설정되고 변화가 적은 매개변수는 학습률을 높게 설정한다.

tf.keras.optimizers.Adagrad(lr=0.01, epsilon=1e-6)

(3) RMSprop

- Adagrad 의 단점 (특정 매개변수의 학습률이 지나치게 떨어진다는 단점) 을 보완한 최적화 방식

tf.keras.optimizers.RMSprop(lr=0.001, rho=0.9, epsilon=1e-06)

(4) Adam

- RMSprop 과 Momentum 두 가지를 합친 방법으로 방향과 학습률 두 가지를 모두 고려한다.

- 현재 제일 많이 사용되는 최적화 방식이다.

tf.keras.optimizers.Adam(lr=0.001, beta_1=0.9, beta_2=0.999, epsilon=None, decay=0.0, amsgrad=False)

4. 역전파

⭐ 오차 계산 후, 경사하강법을 사용해 가중치를 업데이트 하는 과정

https://wikidocs.net/37406 해당 링크를 통해 빠르고 자세하게 이해하기! (정리 PASS)

⭐ Total error 값을 특정 가중치 wi 로 편미분 하는 것이 핵심 (Chain rule)

⭐ 인공 신경망의 학습은 오차를 최소화하는 가중치를 찾는 목적으로 순전파와 역전파를 반복하는 것!

5. Epochs, Batch size, Iteration

- 학습 : 실제값과 예측값의 오차로부터, 옵티마이저를 통해 가중치를 업데이트 하는 과정

- 기계는 똑같은 문제지와 정답지를 주더라도, 학습 방법을 다르게 설정하여 학습할 수 있는데 이에 관련된 파라미터가 epoch, batch size, iteration !

(1) Epochs

- 전체 데이터에 대해 순전파와 역전파가 끝난 상태

- 값이 너무 크거나 너무 작으면 과적합 / 과소적합 문제가 발생할 수 있다.

(2) batch size

- 몇 개의 데이터 단위로 매개변수를 업데이트 하는지를 말한다.

- 현실에 비유하면 문제지에서 몇 개씩 문제를 풀고나서 정답지를 확인하느냐의 문제

- 배치 크기 단위로 학습하면서 샘플 크기 단위마다 가중치를 업데이트 한다.

(3) Iteration (Step)

- 한 번의 에포크를 끝내기 위해 필요한 배치의 수

📌 과적합을 막는 방법

- 과적합 : 훈련 데이터에 포함된 노이즈까지 학습하여, 정작 새로운 데이터 (검증, 테스트 데이터) 에는 제대로 동작하지 않는 상태

👀 인공신경망의 과적합을 막는 방법

1. 데이터의 양을 늘리기

- 데이터의 양이 적으면 특정 패턴이나 노이즈까지 쉽게 학습하게 됨

- 데이터의 양을 늘리면 데이터의 일반적인 패턴을 학습하여 과적합을 방지할 수 있게됨

✔ Data Augmentation

: 기존의 데이터를 조금씩 변형 + 추가 하여 데이터의 양을 의도적으로 늘리는 방법

: 이미지 → 이미지를 돌리거나 노이즈를 추가, 일부분을 수정하는 형태로 증식하는 방법이 있음

: 텍스트 → 재번역을 통해 새로운 데이터를 만들어내는 역번역 (Back Translation) 등의 방법이 있음

2. 모델의 복잡도 줄이기

✔ 은닉층의 수 혹은 매개변수의 수를 조정한다.

3. 가중치 규제 Regularization 적용하기

✔ 간단한 모델 = 적은 수의 매개변수를 가진 모델

✔ 가중치 규제

◾ L1 규제 : 가중치 w들의 절대값 합계를 비용 함수에 추가. w 를 0으로 만들기 때문에 특정한 특성은 모델에 사용되지 않기도 한다. 어떤 특성들이 모델에 영향을 주고 있는지를 정확히 판단하고자 할 때 유용하다.

◾ L2 규제 : 모든 가중치 w들의 제곱합을 비용 함수에 추가. w 를 0에 가까운 값으로 만든다. L1 규제보단 L2 규제의 사용을 권장한다.

◾ Lambda λ : 규제의 강도를 정하는 하이퍼파라미터 → 값이 크면 규제의 강도가 큼을 의미

두 식 모두 비용 함수를 최소화하기 위해서는 가중치 w들의 값이 작아져야 한다는 특징을 가진다.

4. Dropout

- 학습과정에서 신경망의 일부를 사용하지 않는 방법

- 매번 랜덤 선택을 통해 뉴런들을 사용하므로 서로 다른 신경망들을 앙상블 하여 사용하는 효과를 내어 과적합을 방지한다.

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dropout, Dense

max_words = 10000

num_classes = 46

model = Sequential()

model.add(Dense(256, input_shape=(max_words,), activation='relu'))

model.add(Dropout(0.5)) # 드롭아웃 추가. 비율은 50%

model.add(Dense(128, activation='relu'))

model.add(Dropout(0.5)) # 드롭아웃 추가. 비율은 50%

model.add(Dense(num_classes, activation='softmax'))

📌 기울기 소실과 폭주

- 기울기 소실

- 깊은 인공신경망에서의 역전파 과정을 진행할 때 입력층으로 갈수록 기울기가 점차적으로 작아지는 현상

- 해결방법

- 은닉층에서 시그모이드 함수를 사용하지 말것

- 대신 은닉층에서는 ReLU 함수의 변형들을 사용할 것

- 가중치 초기화 방법 : 세이비어 초기화, He 초기화

- 기울기 폭주

- 기울기가 점차 커지더니 비정상적으로 큰 값이 되면서 발산하는 경우

- RNN 에서 쉽게 발생하는 문제이다.

- 해결방법

- Gradient Clipping : 기울기 값을 자르는 것으로 임계값을 설정해 임계치 이상의 기울기는 나오지 않도록 한다.

from tensorflow.keras import optimizers

Adam = optimizers.Adam(lr=0.0001, clipnorm=1.)

- 배치 정규화

- 기울기 소실 혹은 폭주를 완화시키는 방법

- 인공 신경망의 각 층에 들어가는 입력을 평균과 분산으로 정규화하여 학습을 효율적으로 만든다.

- 층 정규화

📌 MLP 로 텍스트 분류하기

👀 20개 뉴스 그룹 데이터 실습

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout

def fit_and_evaluate(X_train, y_train, X_test, y_test):

model = Sequential()

model.add(Dense(256, input_shape=(vocab_size,), activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(128, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(num_classes, activation='softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

model.fit(X_train, y_train, batch_size=128, epochs=5, verbose=1, validation_split=0.1)

score = model.evaluate(X_test, y_test, batch_size=128, verbose=0)

return score[1]

📌 NNLM 피드포워드 신경망 언어모델

- 과거에 자연어를 학습할 땐 통계적인 접근을 사용하였으나, 최근에는 인공신경망을 사용하는 방법이 NLP 에서 더 좋은 성능을 보인다.

- 신경망 언어 모델의 시초인 NNLM

⭐ 언어모델 : 문장에 확률을 할당하는 모델

⭐ 언어 모델링 : 주어진 문맥으로부터 아직 모르는 단어를 예측하는 것

- N-gram 언어 모델의 한계 : 충분한 데이터를 관측하지 못하는 경우, 언어를 정확히 모델링하지 못하는 희소 문제(sparsity problem) 발생

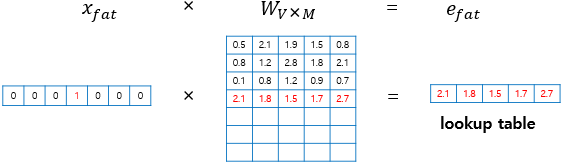

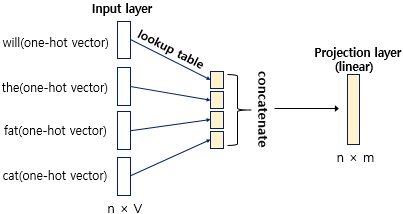

- 단어의 의미적 유사성 : 단어의 의미적 유사성을 학습할 수 있도록 설계한다면, 훈련 코퍼스에 없는 단어 시퀀스에 대한 예측이라도 유사한 단어가 사용된 단어 시퀀스를 참고하여 보다 정확한 예측을 할 수 있다. NNLM 이 이러한 아이디어를 반영한 모델! (+워드 임베딩의 아이디어)

✔ lookup table 과정에서 생성된 단어벡터가 임베딩 벡터!

✔ 투사층에서 모든 임베딩 벡터 값들은 연결된다. (이어붙임)

위와 같은 과정으로 코퍼스를 학습하게 된다면 결과적으로 수많은 문장에서 유사한 목적으로 사용되는 단어들은 결국 유사한 임베딩 벡터값을 얻게된다. 단어 간 유사도를 구할 수 있는 임베딩 벡터의 아이디어는 Word2Vec, FastText, GloVe 등으로 발전되어서 딥 러닝 자연어 처리 모델에서는 필수적으로 사용되는 방법이 되었다.

⭐ NNLM 모델의 이점 : 단어의 유사도 계산이 가능, 희소 문제 해결

⭐ 한계 : (고정된 벡터 길이) 정해진 주변단어 n 개만을 참고하는 문제 (모든 이전 단어를 참고할 수 없음) 👉 RNN 을 통해 해결

'1️⃣ AI•DS > 📗 NLP' 카테고리의 다른 글

| [cs224n] 6강 내용 정리 (0) | 2022.03.24 |

|---|---|

| [cs224n] 5강 내용 정리 (0) | 2022.03.22 |

| [cs224n] 4강 내용 정리 (0) | 2022.03.18 |

| [cs224n] 3강 내용 정리 (0) | 2022.03.14 |

| [cs224n] 2강 내용 정리 (0) | 2022.03.14 |

댓글